Screaming Frog Seo Spider для парсинга сайта: подробная инструкция для новичков

Если вам нужно просто собрать с сайта метаданные, можно воспользоваться бесплатным парсером Promopult. Но бывает, что надо копать гораздо глубже и добывать больше данных, и тут уже без сложных (и небесплатных) инструментов не обойтись.

Рассказываем, как спарсить любой сайт, даже если вы совсем не дружите с программированием. Разбор сделан на примере Screaming Frog Seo Spider.

Оглавление

- Что такое парсинг и зачем он нужен

- ПО для парсинга

- Быстрый старт с Screaming Frog

- Пример 1. Как спарсить цену

- Пример 2. Как спарсить фотографии

Что такое парсинг и зачем он нужен

Парсинг нужен, чтобы собрать данные с различных ресурсов. Например, собрать данные о ценах конкурентов. Еще один способ применения — это наполнение каталога новыми товарами на основе уже существующих сайтов в интернете.

Упрощенно, парсинг — это сбор структурированной информации. Чаще всего — в виде таблицы с конкретным набором данных. Например, данных по характеристикам товаров. Есть более сложные определения, но так как мы даем инструкцию «для чайников», то нет никакого смысла усложнять терминологию.

Парсер — программа, которая осуществляет этот сбор. Она обходит указанные URL и собирает нужную информацию в Excel-файл либо куда-то еще.

Парсинг работает на основе XPath-запросов. XPath — язык запросов, который обращается к определенному участку страницы и собирает из него заданную информацию.

ПО для парсинга

Здесь есть важный момент. Если вы введете в поисковике слово «парсинг» или «заказать парсинг», то, как правило, увидите услуги от компаний, которые создадут парсер под ваши задачи. Стоят такие услуги относительно дорого. В результате программисты под заказ напишут некую программу либо на Python, либо на каком-то еще языке, которая будет собирать нужные данные с выбранного ресурса. Эта программа нацелена только на сбор конкретных данных, она не гибкая и без знаний программирования вы не сможете ее самостоятельно перенастроить для других задач.

При этом есть готовые решения, которые можно под себя настраивать как угодно и собирать что угодно. Более того, если вы — SEO-специалист, возможно, одной из этих программ вы уже пользуетесь, но просто не знаете, что в ней есть такой функционал. Либо знаете, но никогда не применяли, либо применяли не в полной мере.

В рамках этой статьи рассмотрим Screaming Frog SEO Spider. Эта программа занимается сбором информации с сайта. То есть анализирует, например, его заголовки, теги и всё остальное. Помимо прочего, она позволяет собрать те данные, которые вы зададите.

Профессиональные инструменты PromoPult: быстрее, чем руками, дешевле, чем у других, бесплатные опции.

Съем позиций, кластеризация запросов, парсер Wordstat, сбор поисковых подсказок, сбор фраз ассоциаций, парсер метатегов и заголовков, анализ индексации страниц, генератор из YML, парсер ИКС Яндекса, нормализатор и комбинатор фраз, парсер сообществ и пользователей ВКонтакте, AI генератор изображений.

Реклама. ООО «Клик.ру», ИНН:7743771327, ERID: 2Vtzqur3WXR

Давайте смотреть на реальных примерах.

Быстрый старт с Screaming Frog

Screaming Frog SEO Spider — один из самых удобных инструментов для парсинга сайтов. У него простой интерфейс, много фильтров и настроек для парсинга. Программа подходит для работы как с небольшими сайтами, так и с крупными проектами. Устанавливается на Windows, macOS и Linux, интерфейс доступен на английском.

Загрузка и лицензия

Screaming Frog можно скачать бесплатно с официального сайта. Бесплатная версия ограничена 500 URL-адресами на один запуск — этого достаточно для тестов и небольших проектов. Чтобы убрать лимит и использовать расширенные функции, потребуется лицензия стоимостью $279 в год. Одна лицензия выдается на одного пользователя.

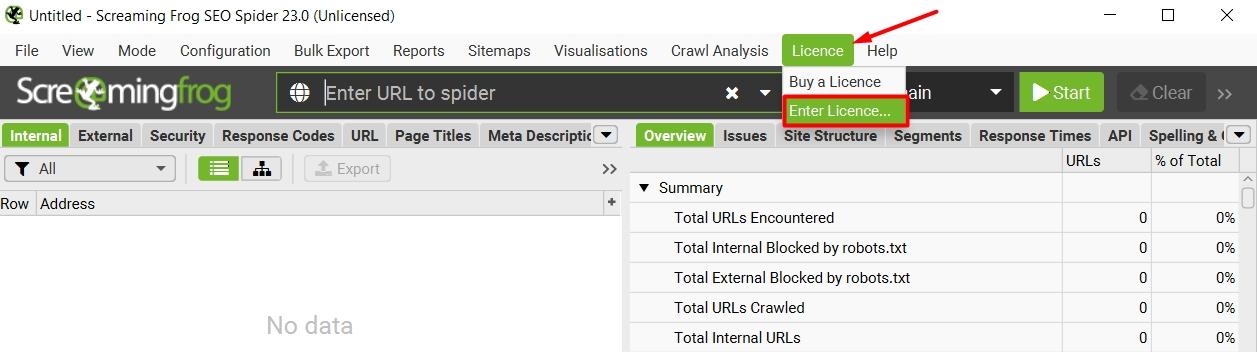

Купленный ключ нужно активировать через меню Licence → Enter Licence.

Введите имя пользователя и полученный ключ.

Режимы работы

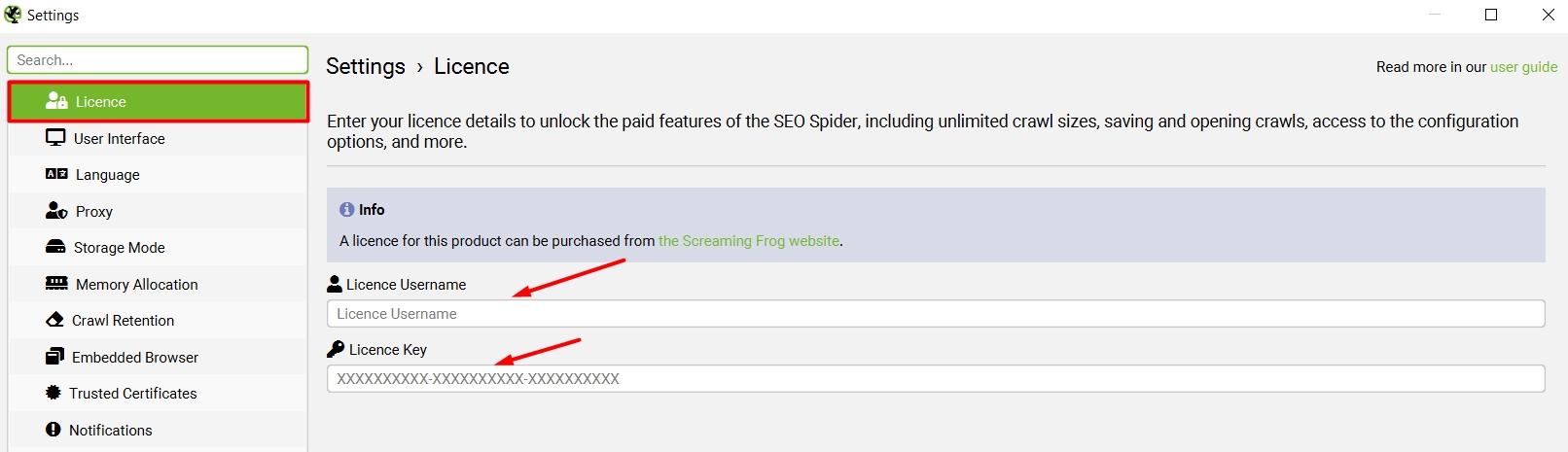

Инструмент поддерживает несколько режимов работы:

- Spider — базовый режим. Он сканирует весь сайт, начиная с указанного URL, переходит по внутренним ссылкам, собирает данные о страницах и всех ссылках, а затем выстраивает полную карту сканируемого проекта. Полезен, когда нужно провести полный SEO-аудит, найти битые страницы, проанализировать структуру сайта, метаданные и перелинковку.

- List — режим проверки сайта по конкретному списку страниц. Загрузить список URL можно через файл .txt, .csv, .xlsx или вручную. Также можно проанализировать сайт по XML-карте, для этого нужно выбрать Upload → Download Sitemap.

- Compare — режим для сравнения двух сканирований сайта. Он помогает быстро увидеть изменения: появились ли новые страницы, пропали ли старые, изменились ли метатеги, заголовки или коды ответов. Например, можно сравнить мобильную и десктопную версии сайта, тестовую и основную, или просто два аудита, проведенные в разное время.

- SERP — позволяет загружать список URL в CSV или XLS и просматривать, как будут выглядеть сниппеты этих страниц в поисковой выдаче. Полезно для анализа мета-заголовков и описаний, особенно при SEO-оптимизации.

- APIs — режим интеграции с внешними сервисами. Парсер может подключаться к Google Analytics, Search Console, PageSpeed Insights, Ahrefs и другим источникам данных. При сканировании инструмент добавляет информацию из этих систем — например, данные о трафике, кликах, ссылках и показателях производительности страниц.

Базовые настройки для быстрого старта

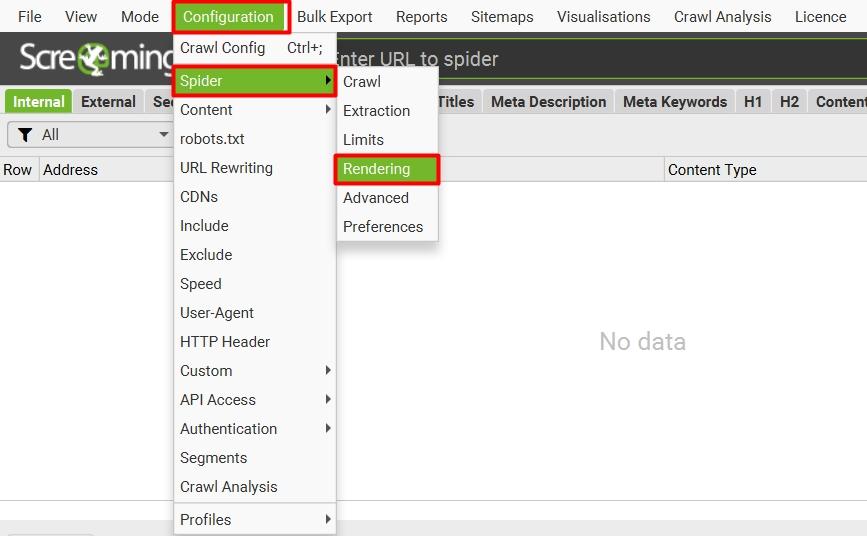

1. Включите загрузку JavaScript. Тогда инструмент будет «видеть» всю информацию на странице так же, как обычный пользователь в браузере. Без этой опции парсер может пропустить динамически подгружаемый контент — цены, описания, отзывы и ссылки. Для включения JS откройте меню Configuration → Spider → Rendering → JavaScript Rendering.

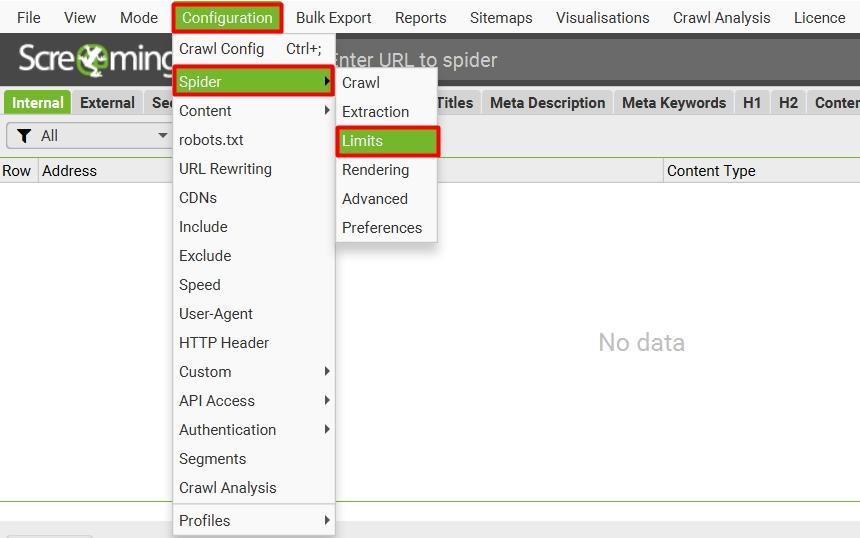

2. Установите лимиты и глубину сканирования. Откройте меню Configuration → Spider → Limits. Задайте Limit Crawl Total — максимальное число страниц, которые будут просканированы, и Limit Crawl Depth — ограничение глубины ссылок от стартовой страницы. Параметры зависят от размера и структуры сайта.

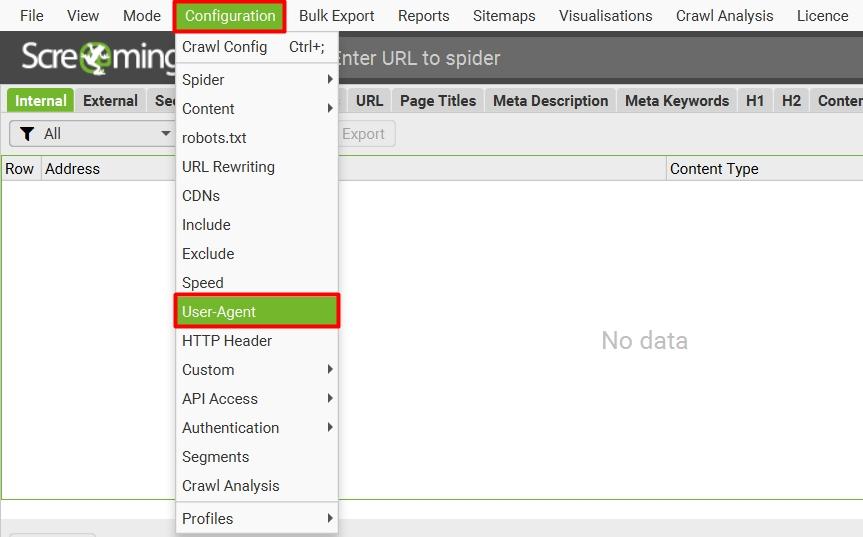

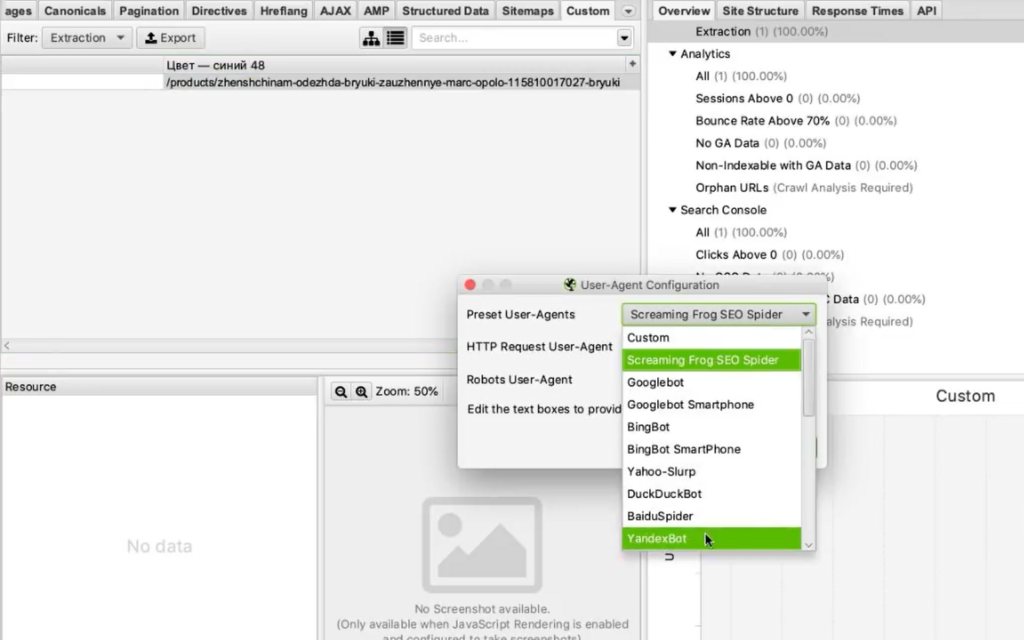

3. Выберите подходящий User-Agent. Screaming Frog при сканировании идентифицирует себя как определенный бот. Чтобы сайты не блокировали парсер и результаты были точными, выберите в Configuration → User-Agent подходящий вариант, например YandexBot или Googlebot.

4. Отключите ненужные элементы для ускорения сканирования. Если вам не нужны изображения, CSS или внешние ссылки, перейдите в Configuration → Spider и снимите галочки с опций Images, CSS, External Links. Это сэкономит ресурсы и ускорит работу.

5. Настройте скорость сканирования. В Configuration → Speed можно ограничить количество одновременных соединений и задержку между запросами. Это снизит риск блокировки со стороны сайтов и уменьшит нагрузку на сервер.

6. Настройте автосохранение. В меню Configuration → Save → Auto Save включите автоматическое сохранение данных после сканирования, чтобы не потерять результаты при сбое или закрытии программы.

Пример 1. Как спарсить цену

Предположим, вы хотите с веб-ресурса собрать все цены товаров. Это ваш конкурент, и вы хотите узнать, сколько у него стоят товары.

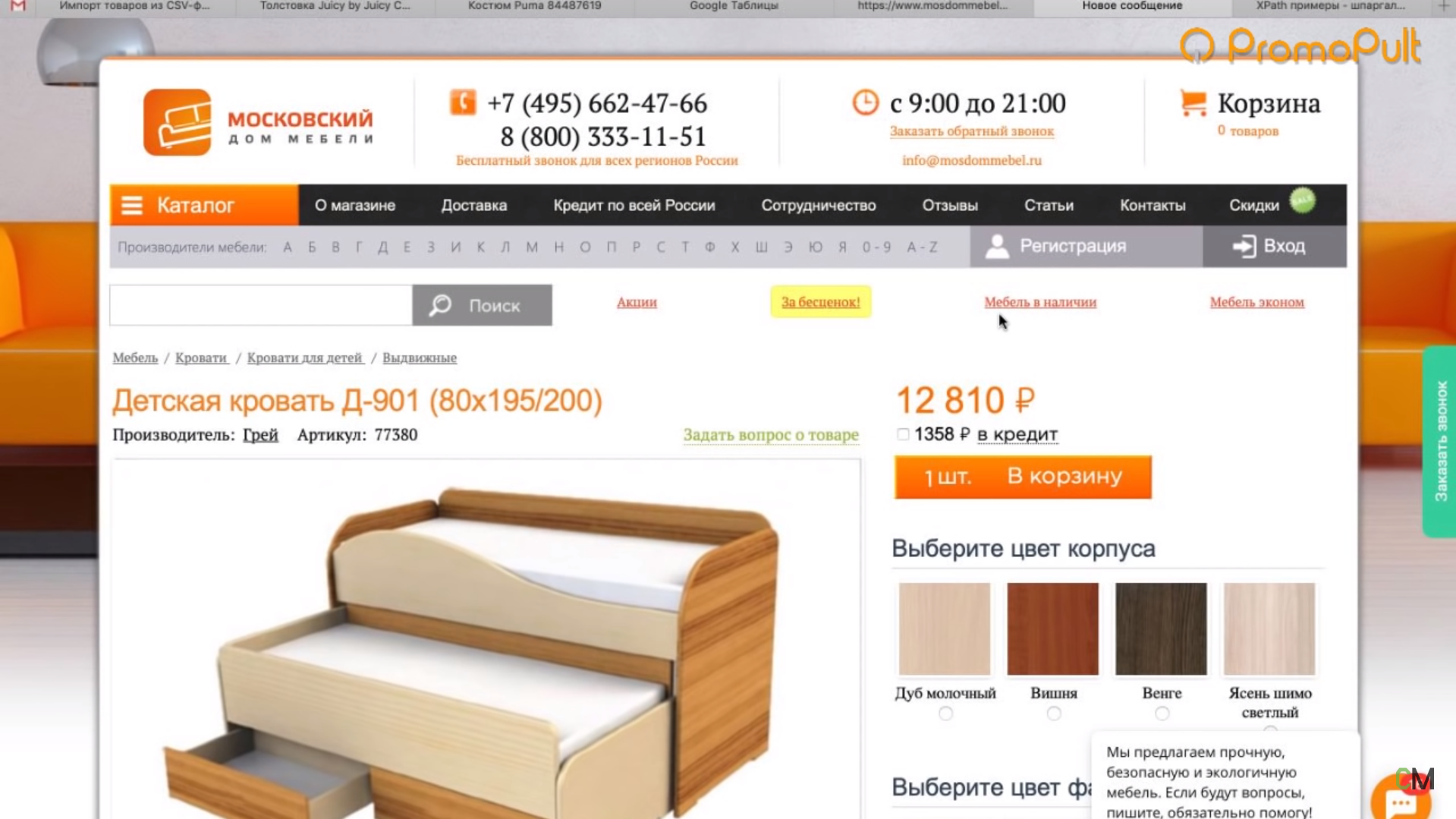

Возьмем для примера проект mosdommebel.ru.

У нас есть страница карточки товара, есть название и есть цена этого товара. Как нам собрать эту цену и цены всех остальных товаров?

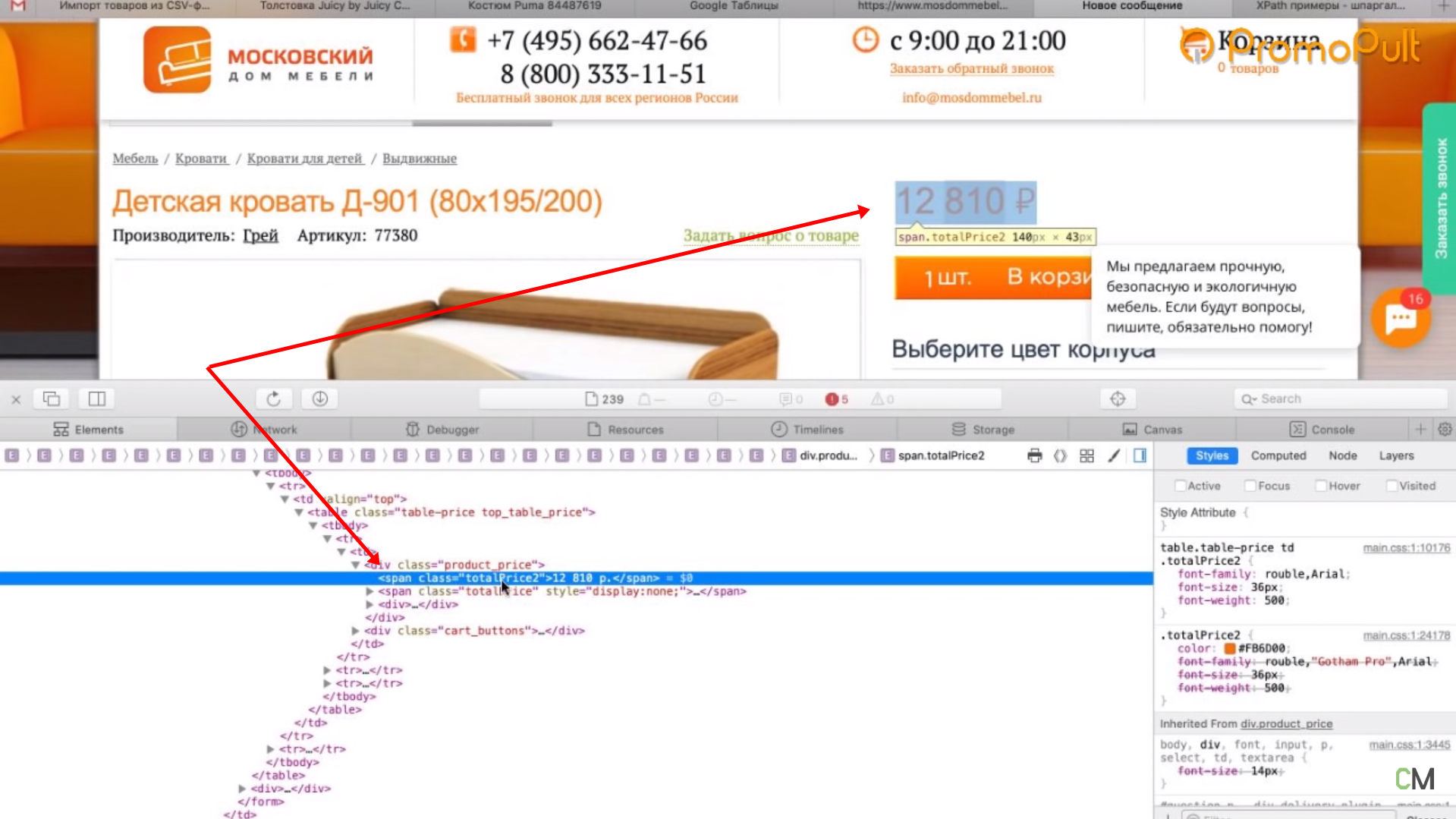

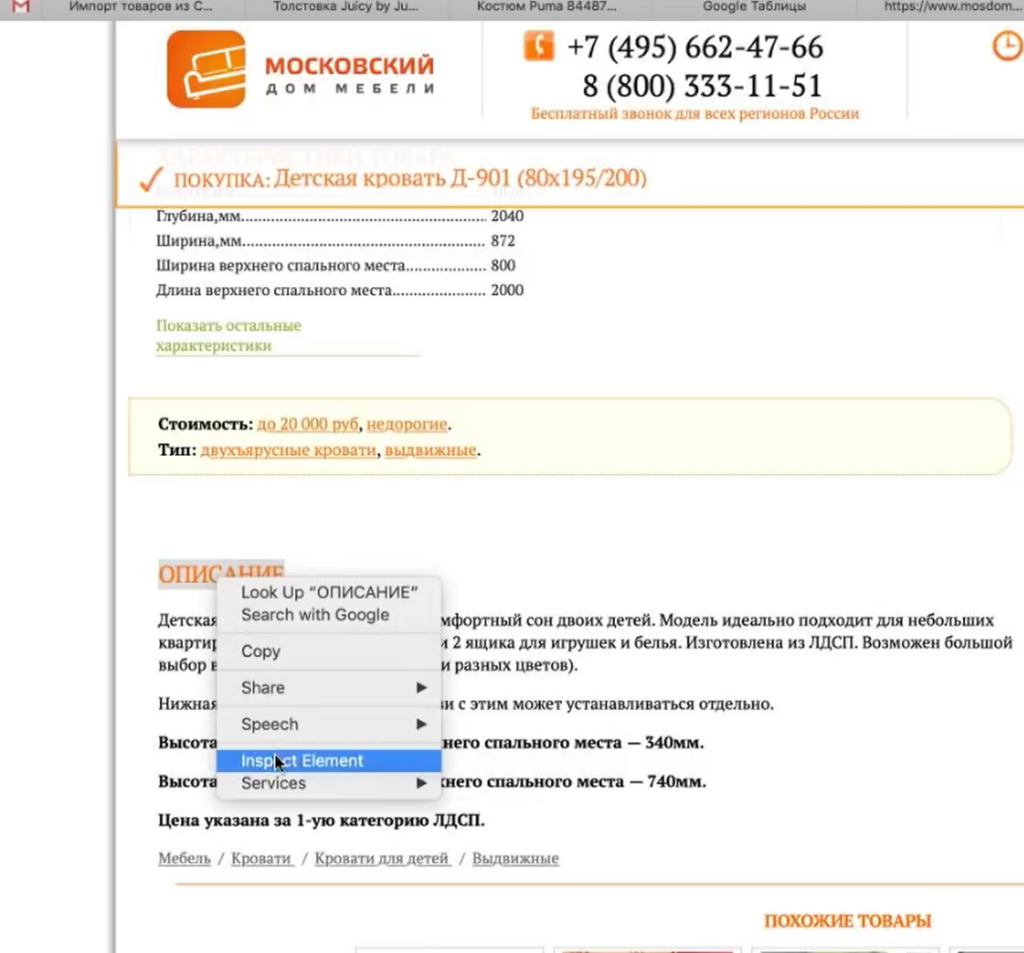

Мы видим, что цена отображается вверху справа, напротив заголовка h1. Теперь нам нужно посмотреть, как эта цена отображается в HTML.

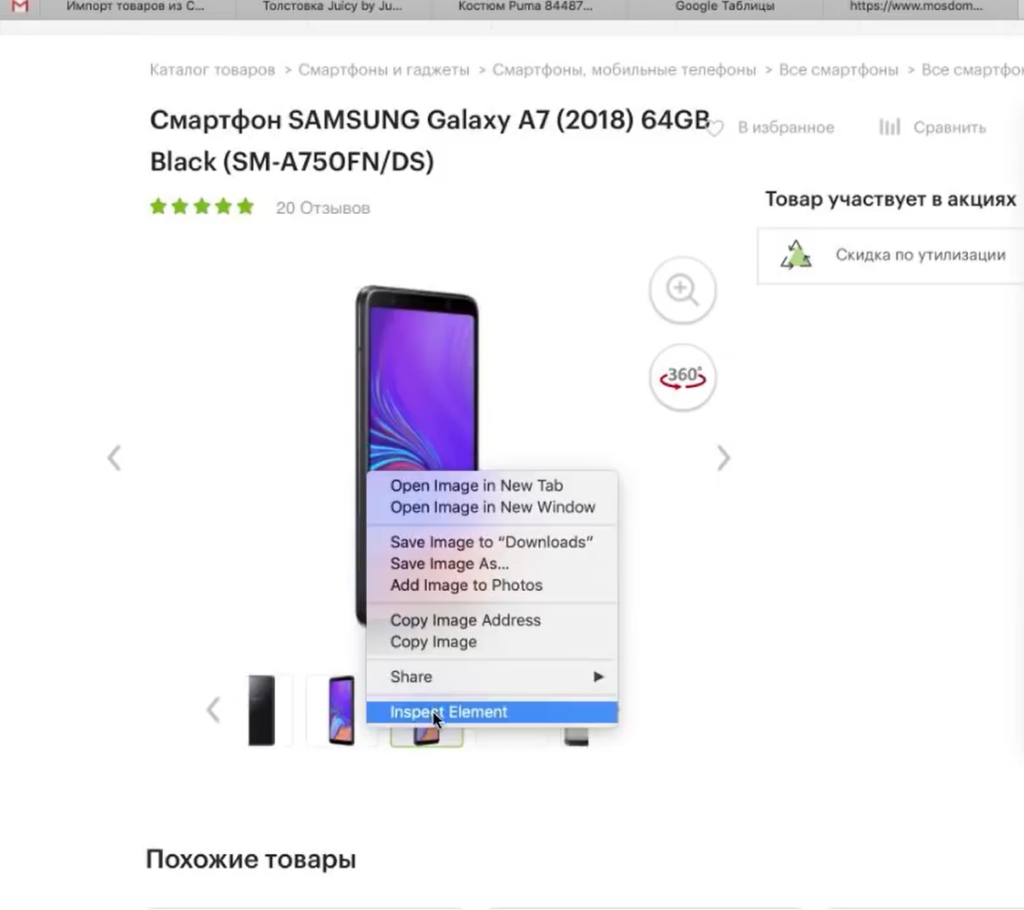

Нажимаем правой кнопкой мыши прямо на цену (не просто на какой-то фон или пустой участок). Затем выбираем пункт Inspect Element для того, чтобы сразу его определить (Исследовать элемент или Просмотреть код элемента, в зависимости от браузера — прим. ред.).

Мы видим, что цена у нас помещается в тег <span> с классом totalPrice2. Так разработчик обозначил стоимость данного товара, которая отображается в карточке.

Фиксируем: есть некий элемент span с классом totalPrice2. Пока это держим в голове.

Есть два варианта работы с парсерами.

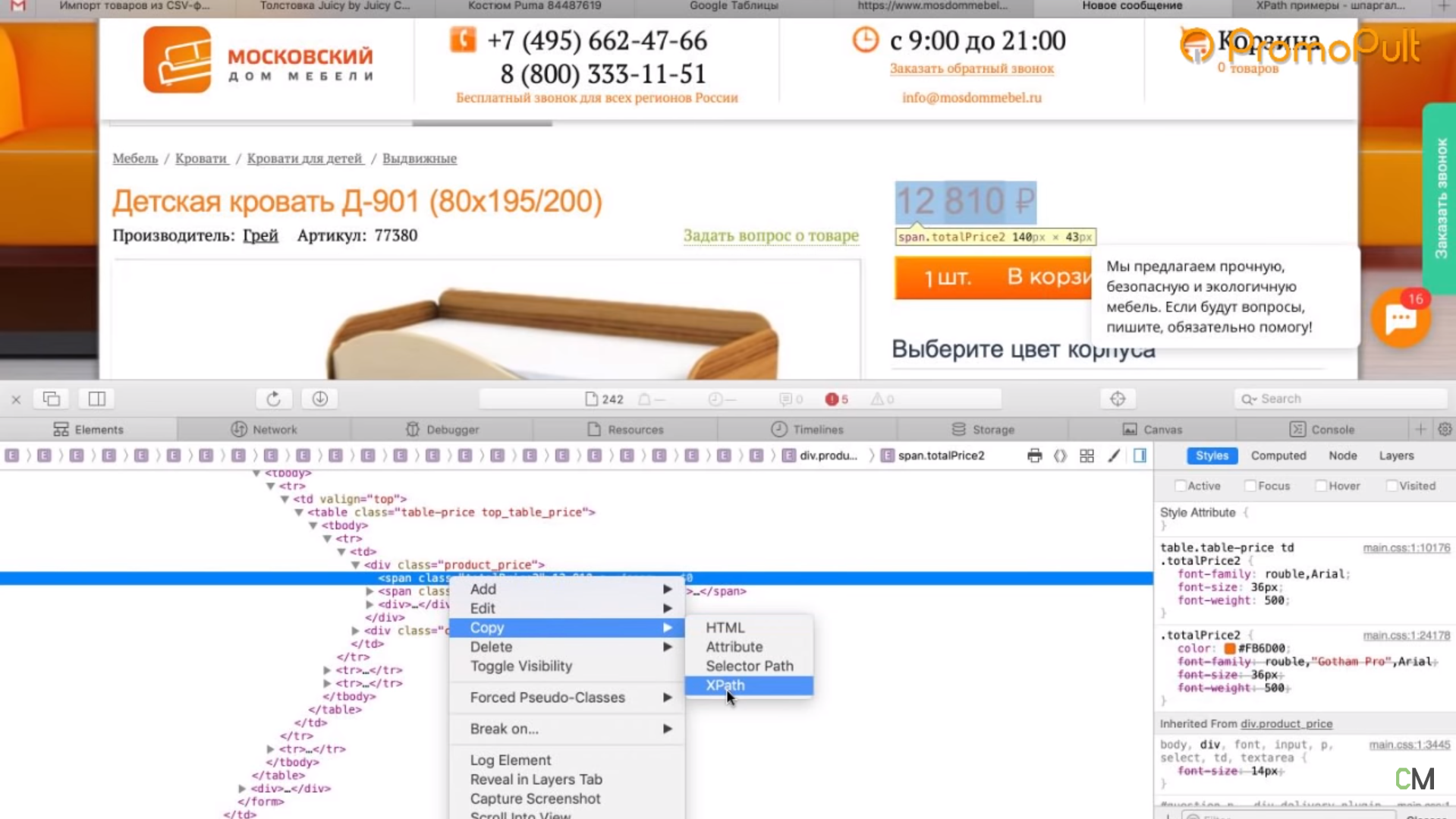

Первый способ. Вы можете прямо в коде (любой браузер) нажать правой кнопкой мыши на тег <span> и выбрать Скопировать > XPath. У вас таким образом скопируется строка, которая обращается к данному участку.

Выглядит она так:

/html/body/div[1]/div[2]/div[4]/table/tbody/tr/td/div[1]/div/table[2]/tbody

/tr/td[2]/form/table/tbody/tr[1]/td/table/tbody/tr[1]/td/div[1]/span[1]

Но этот вариант не очень надежен: если у вас в другой карточке товара верстка выглядит немного иначе (например, нет каких-то блоков или блоки расположены по-другому), то такой метод обращения может ни к чему не привести. И нужная информация не соберется.

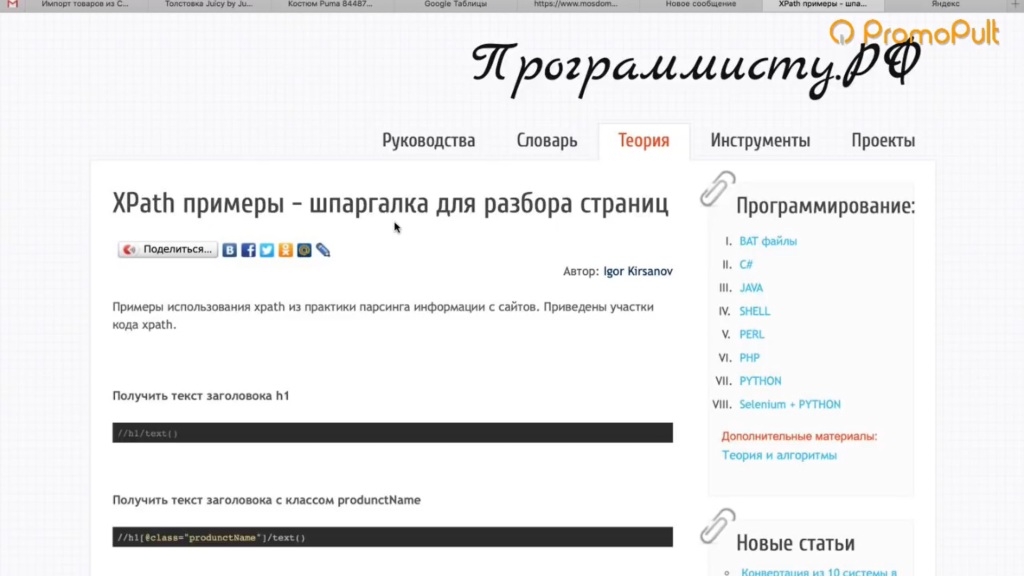

Поэтому мы будем использовать второй способ. Есть специальные справки по языку XPath. Их очень много, можно просто загуглить «XPath примеры».

Например, такая справка:

Здесь указано как что-то получить. Например, если мы хотим получить содержимое заголовка h1, нам нужно написать вот так:

//h1/text()

Если мы хотим получить текст заголовка с классом productName, мы должны написать вот так:

//h1[@class="productName"]/text()

То есть поставить «//» как обращение к некому элементу, написать тег h1 и указать в квадратных скобках через символ @ «класс равен такому-то».

То есть не копировать что-то и не собирать информацию по частям. А написать строку запроса, который обращается к нужному элементу. Куда ее написать — сейчас мы разберемся.

Куда вписывать XPath-запрос

Мы идем в Screaming Frog Seo Spider.

Предположим, вы оплатили годовую лицензию и получили доступ к полному набору функций сервиса. Если вы серьезно занимаетесь анализом данных и регулярно нуждаетесь в функционале сервиса — это разумная трата денег.

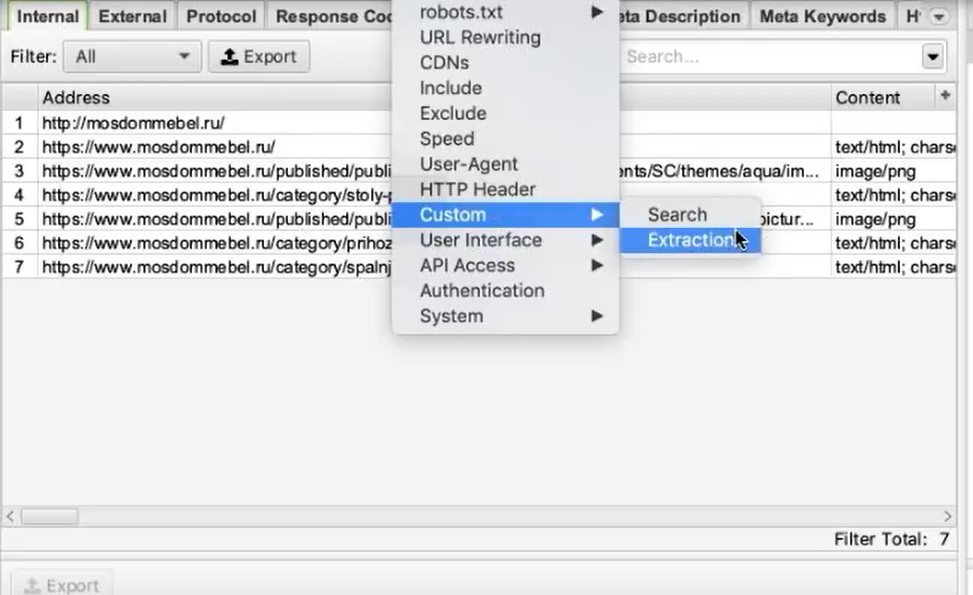

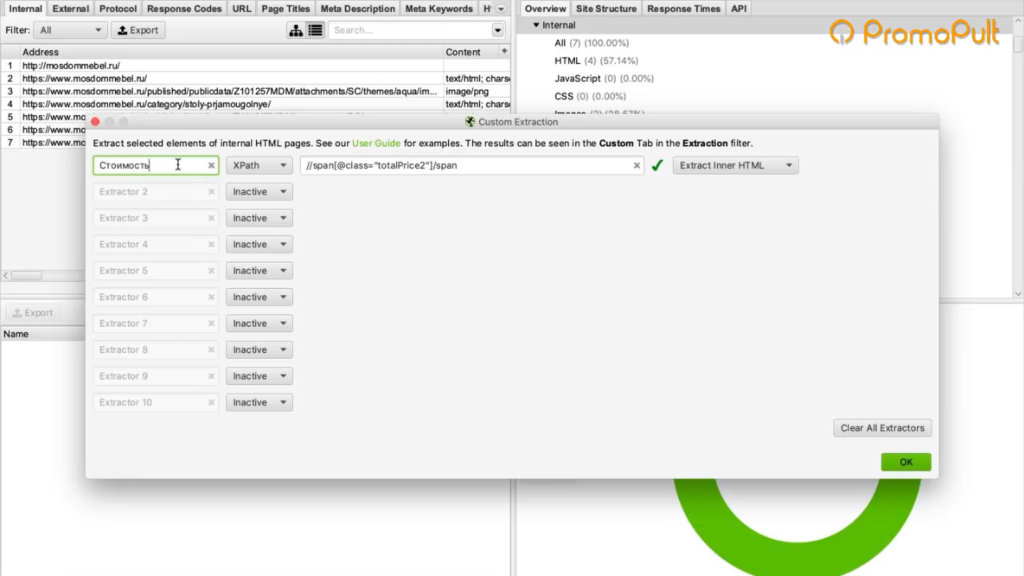

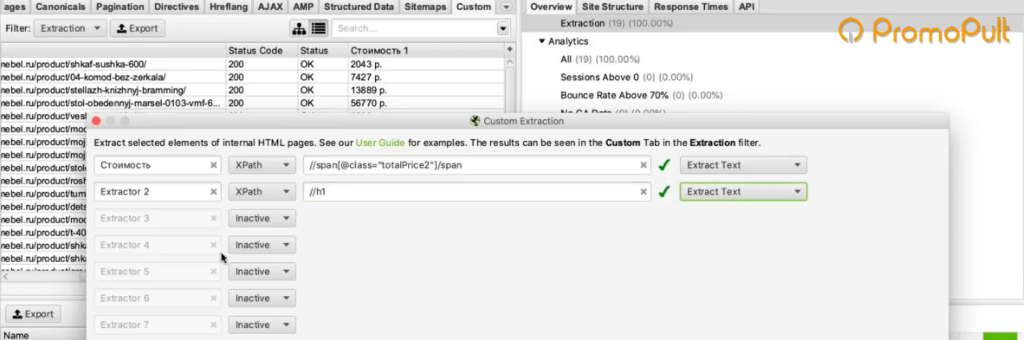

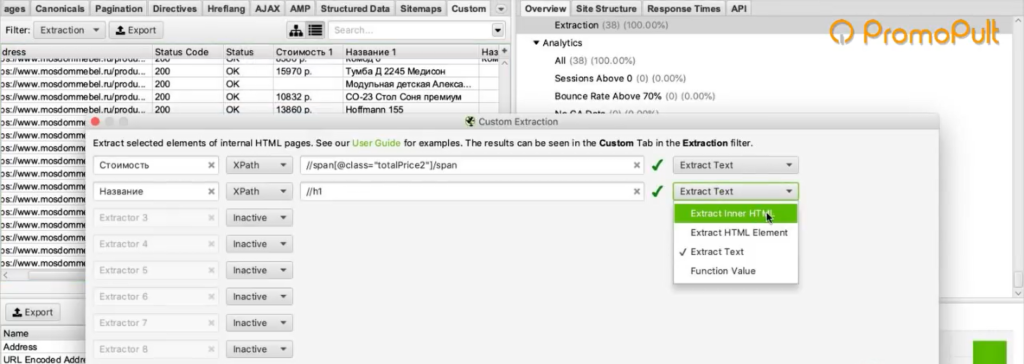

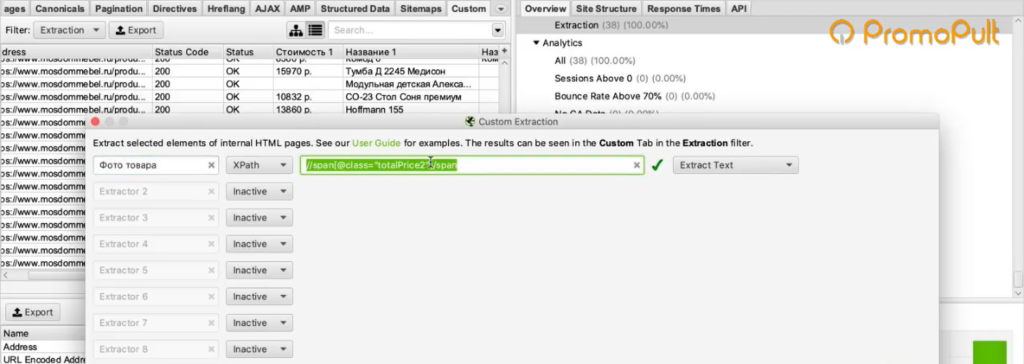

Во вкладке меню Configuration у нас есть подпункт Custom, и в нем есть еще один подпункт Extraction. Здесь мы можем дополнительно что-то поискать на тех страницах, которые мы укажем.

Заходим в Extraction. Нам нужно с сайта Московского дома мебели собрать цены товаров.

Мы выяснили, что у нас все цены на карточках товара обозначаются тегом <span> с классом totalPrice2. Формируем вот такой XPath запрос:

//span[@class="totalPrice2"]/span

И указываем его в разделе Configuration > Custom > Extractions. Для удобства можем назвать как-нибудь колонку, которая у нас будет выгружаться. Например, «стоимость»:

Таким образом мы будем обращаться к коду страниц и из него вытаскивать содержимое стоимости.

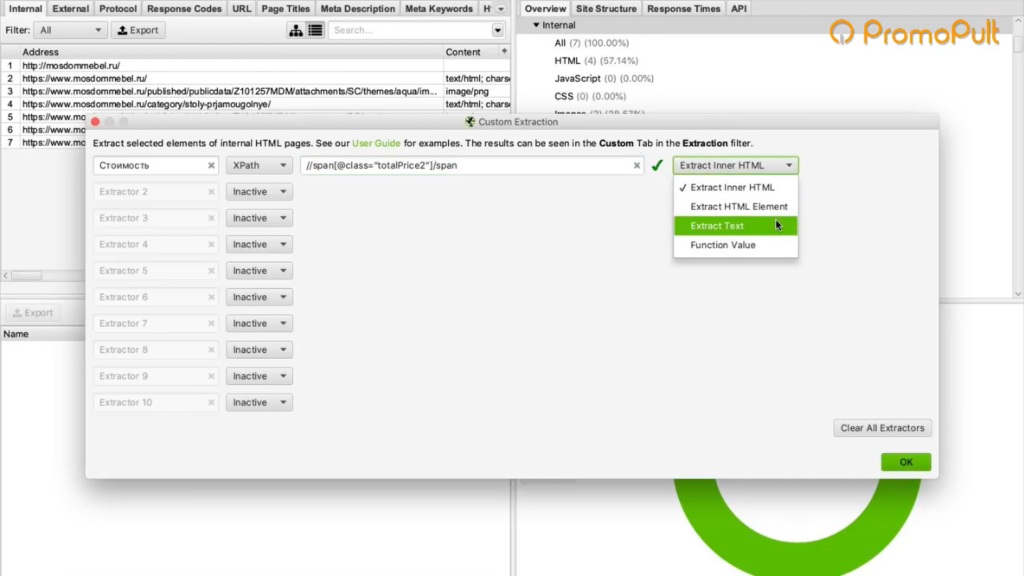

Также в настройках мы можем указать, что парсер будет собирать: весь HTML или только текст. Нам нужен только текст, без разметки, стилей и других элементов.

Нажимаем ОК. Мы задали кастомные параметры.

Как подобрать страницы для парсинга

Дальше есть еще один важный этап — подбор страниц, по которым будет осуществляться парсинг.

Если мы просто укажем адрес ресурса, парсер пойдет по всем страницам. На инфостраницах и разделах у нас нет цен, а нам нужны именно цены, которые указаны на карточках товара. Чтобы не тратить время, лучше загрузить в парсер конкретный список url-адресов, по которым мы будем ходить, — карточки товаров.

Откуда их взять? Как правило, на большинстве ресурсов есть карта сайта XML, и находится она чаще всего по адресу: «адрес сайта/sitemap.xml». В случае с проектом из нашего примера — это адрес:

https://www.mosdommebel.ru/sitemap.xml.

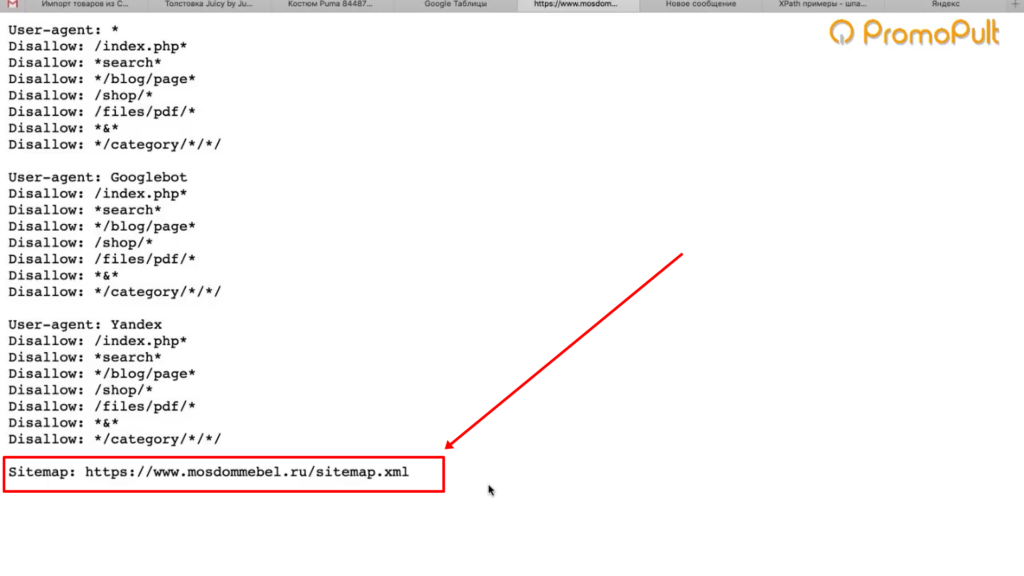

Либо вы можете зайти в robots.txt (site.ru/robots.txt) и посмотреть. Чаще всего в этом файле внизу содержится ссылка на карту сайта.

Даже если карта называется как-то странно, необычно, нестандартно, вы все равно увидите здесь URL.

Но если не увидите — если Sitemap нет — то нет никакого решения для отбора карточек товара. Тогда придется запускать стандартный режим в парсере — он будет ходить по всем разделам сайта. Но нужную вам информацию соберет только на карточках товара. Минус здесь в том, что вы потратите больше времени и дольше придется ждать нужных данных.

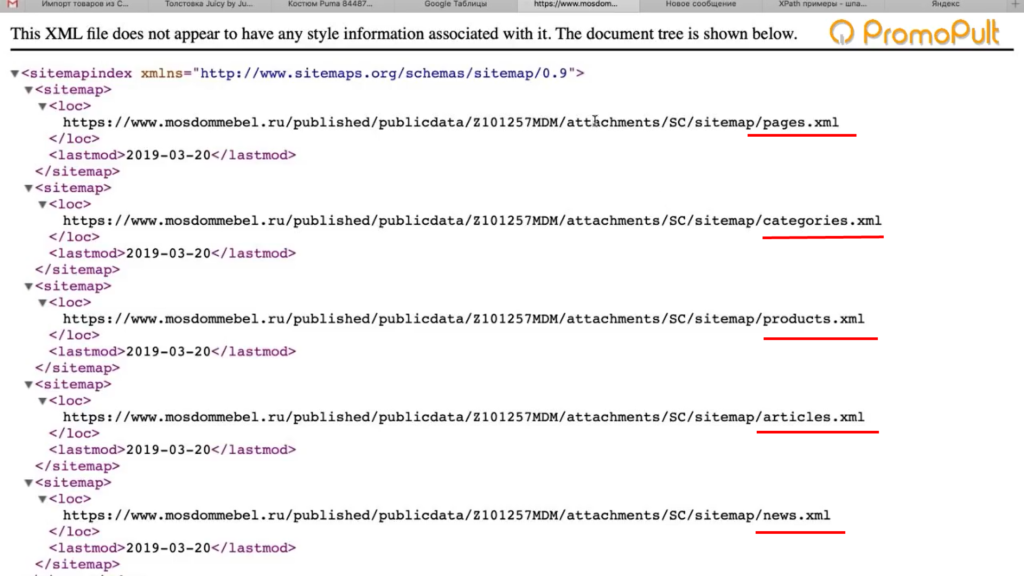

У нас карта сайта есть, поэтому мы переходим по ссылке https://www.mosdommebel.ru/sitemap.xml и видим, что сама карта разделяется на несколько карт. Отдельная карта по статичным страницам, по категориям, по продуктам (карточкам товаров), по статьям и новостям.

Нас интересует карта продуктов, то есть карточек товаров.

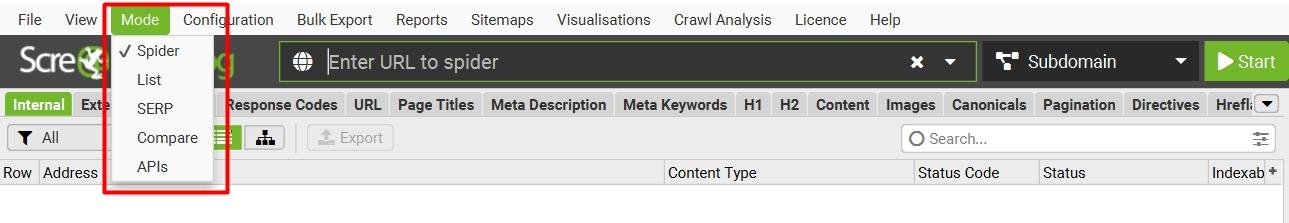

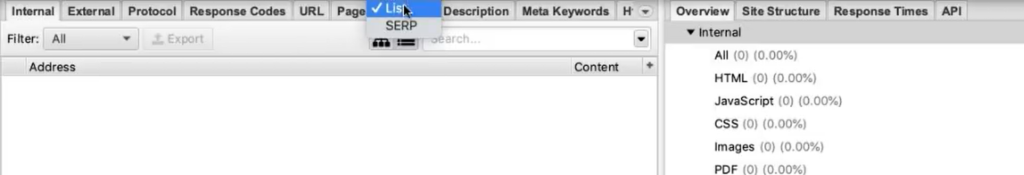

Возвращаемся в Seo Spider. Сейчас он запущен в стандартном режиме, в режиме Spider (паук), который ходит по всему ресурсу и анализирует все разделы. Нам нужно его запустить в режиме List.

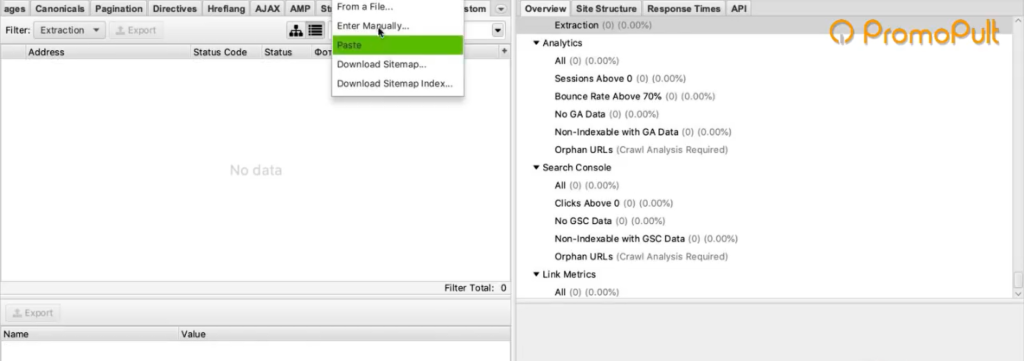

Мы загрузим ему конкретный список адресов, по которому он будет ходить. Нажимаем на вкладку Mode и выбираем List.

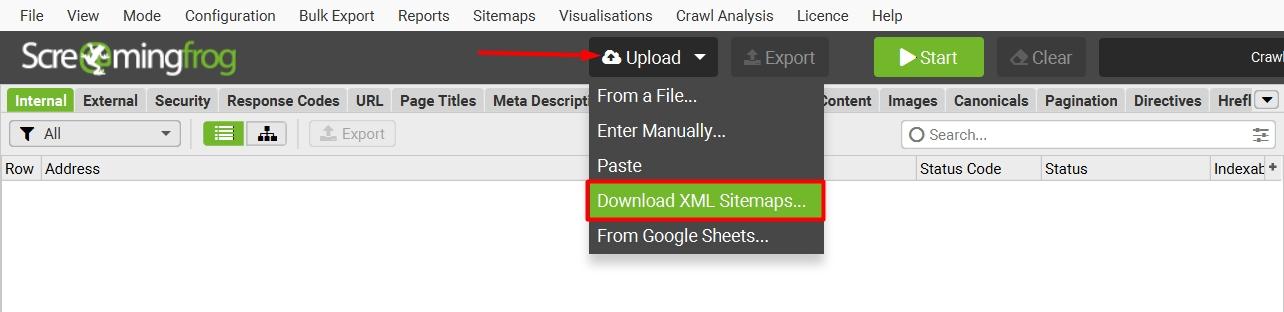

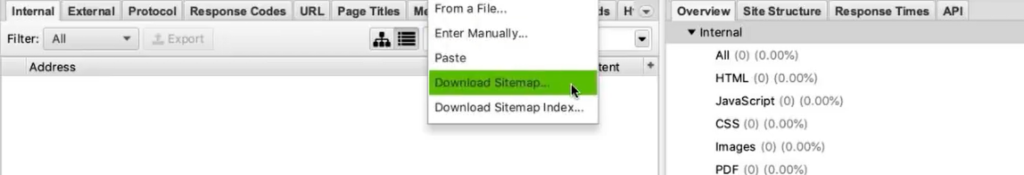

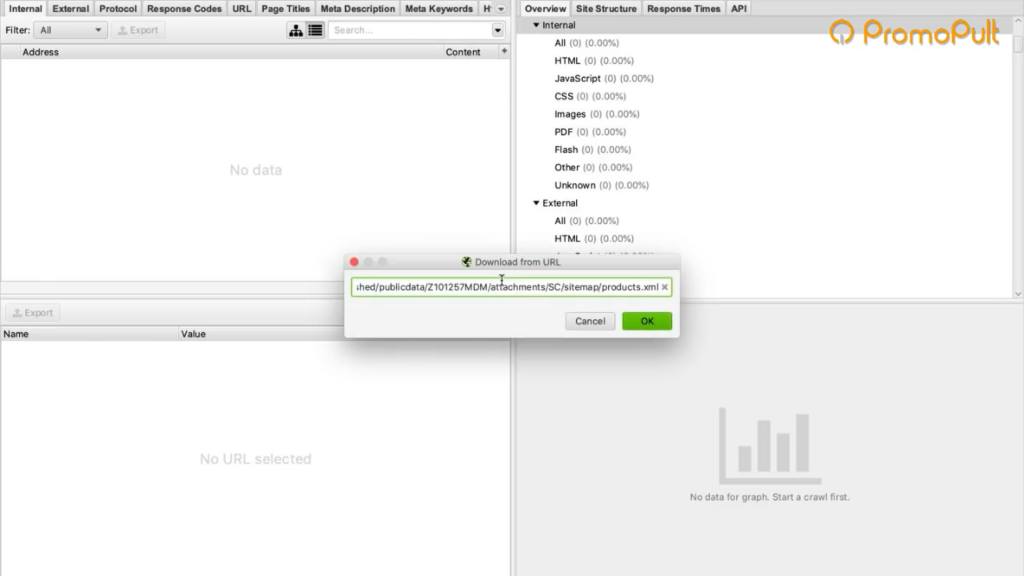

Жмем кнопку «Upload» и кликаем по «Download Sitemap».

Указываем адрес Sitemap карточек товара, нажимаем ОК.

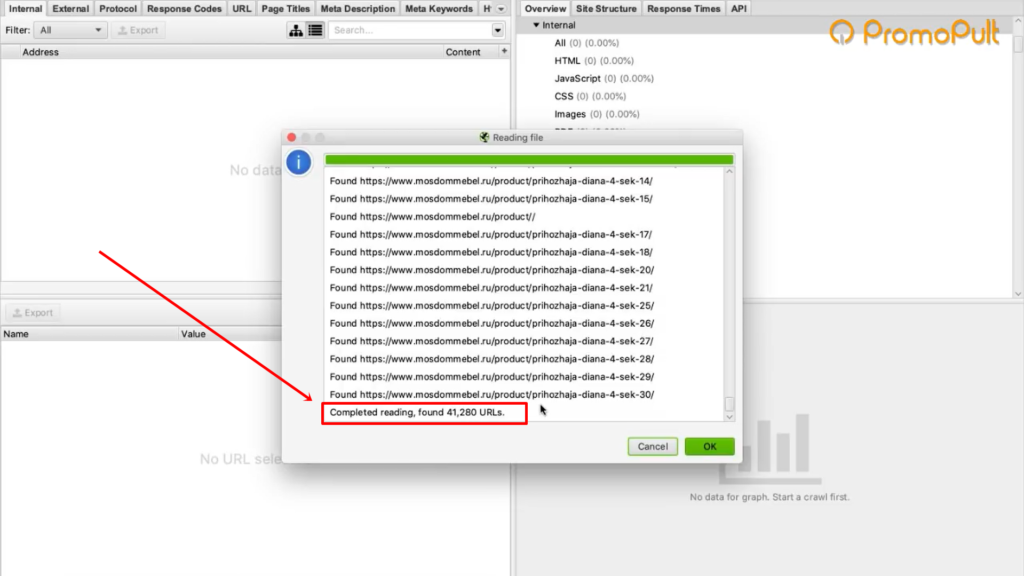

Программа скачает все URL, указанные в Sitemap. В нашем случае парсер обнаружил более 40 тысяч ссылок на карточки товаров:

Нажимаем ОК, и у нас начинается процесс сбора ссылок.

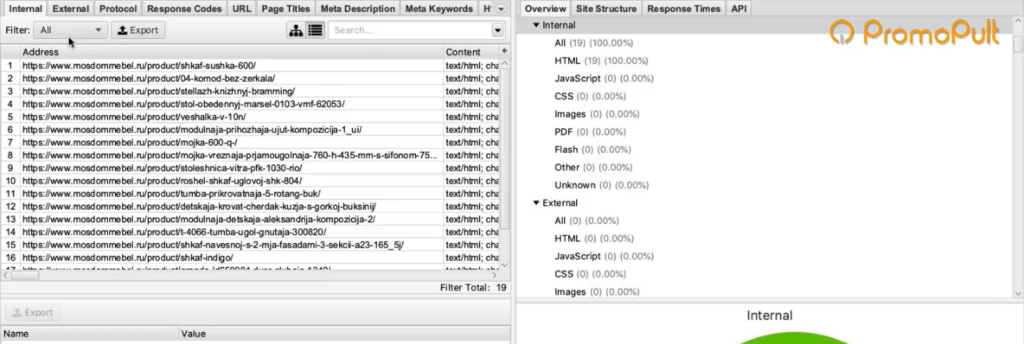

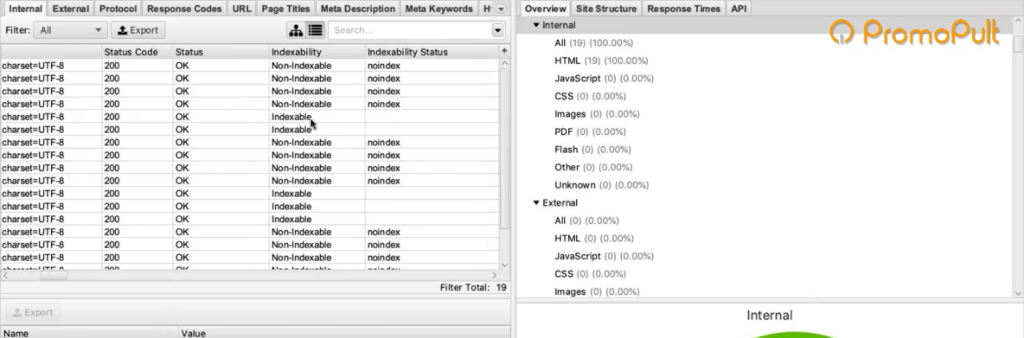

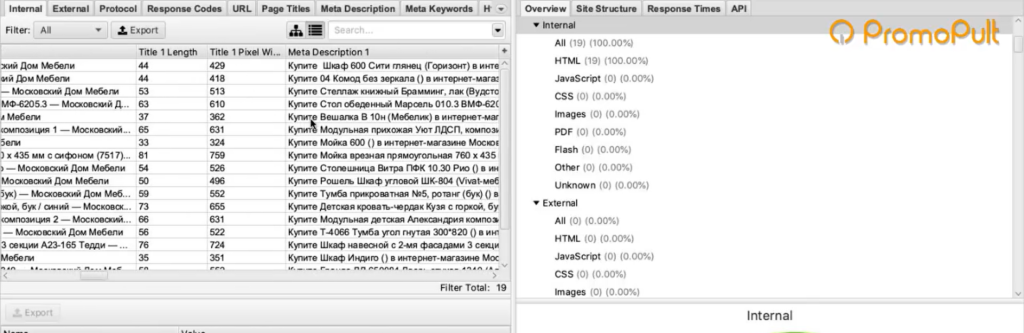

После завершения процесса на первой вкладке Internal мы можем посмотреть информацию по всем характеристикам: код ответа, индексируется/не индексируется, title, description и все остальное.

Это все полезная информация, но мы шли за другим.

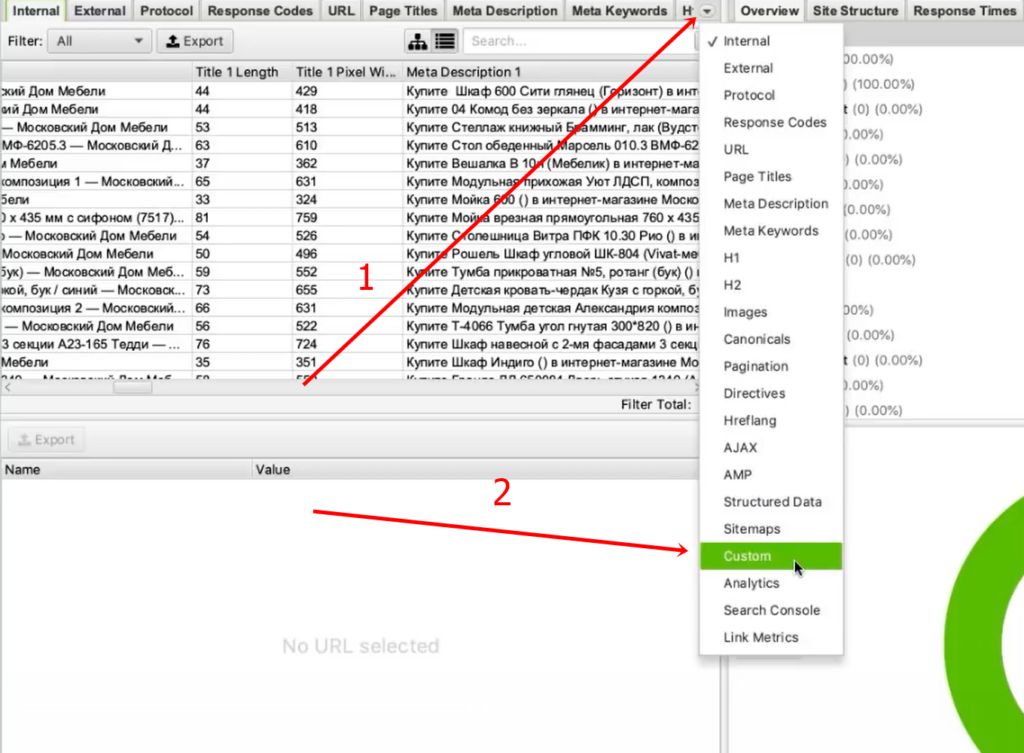

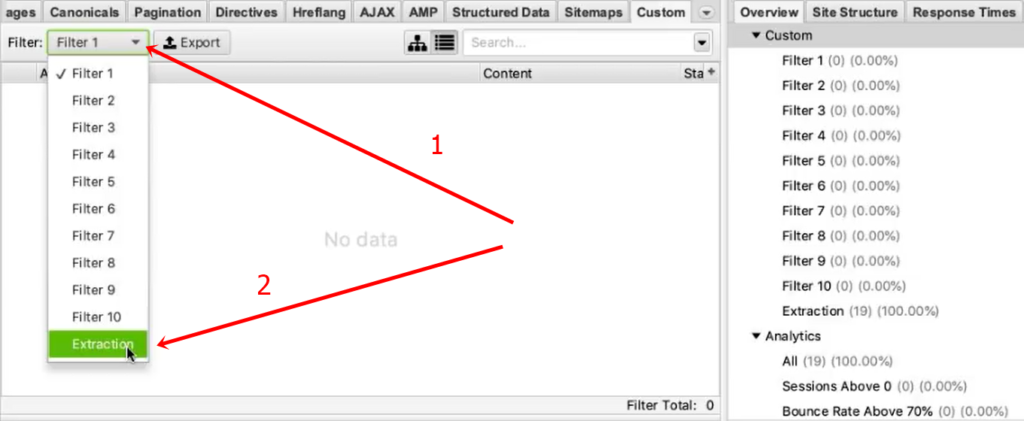

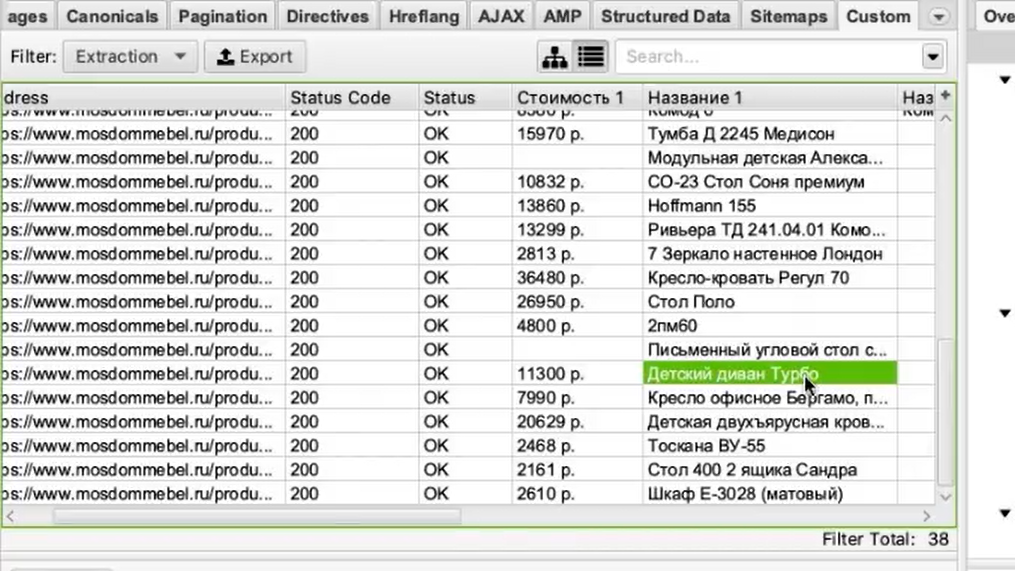

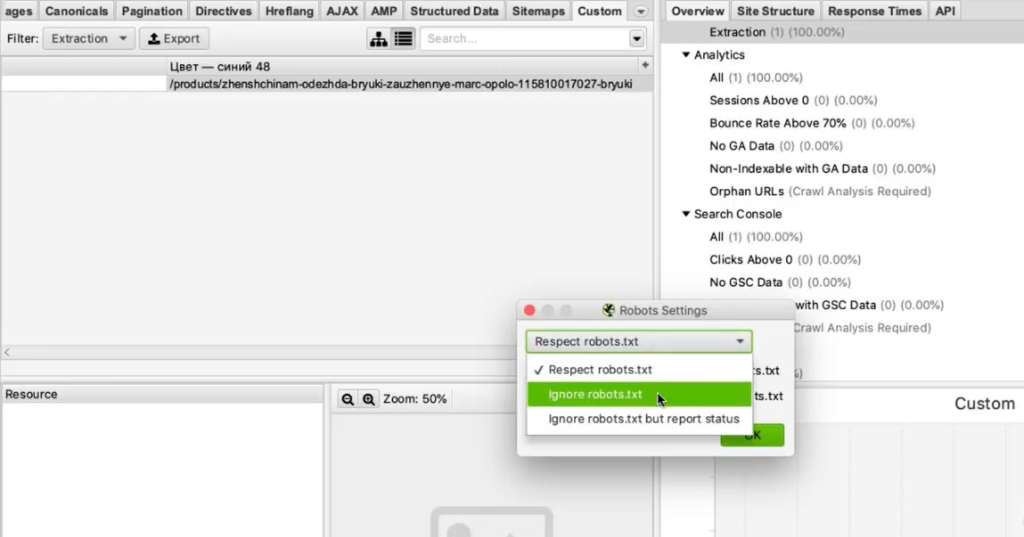

Вернемся к исходной задаче — посмотреть стоимость товаров. Для этого в интерфейсе программы нам нужно перейти на вкладку Custom. Чтобы попасть на нее, нужно нажать на стрелочку, которая находится справа от всех вкладок. Из выпадающего списка выбрать пункт Custom.

И на этой вкладке из выпадающего списка фильтров (Filter) выберите Extraction.

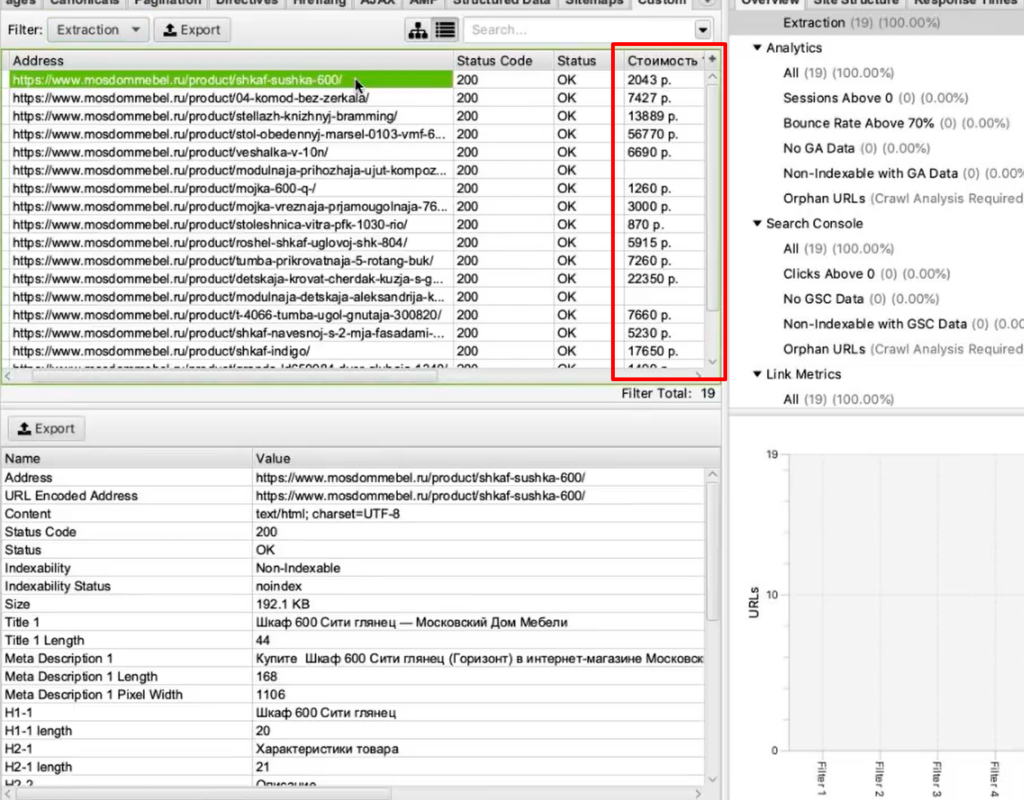

Вы как раз и получите ту самую информацию, которую хотели собрать: список карточек и колонка «Стоимость 1» с ценами в рублях.

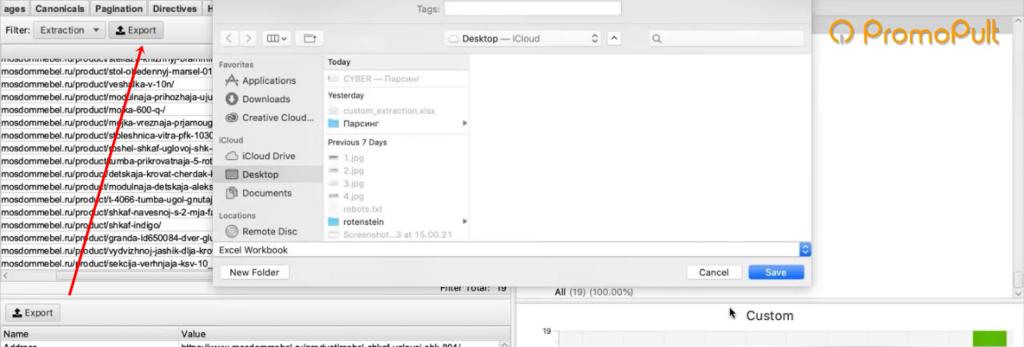

Задача выполнена, теперь все это можно выгрузить в xlsx или csv-файл.

После выгрузки стандартной заменой вы можете убрать букву «р», которая обозначает рубли. Просто, чтобы у вас были цены в чистом виде, без пробелов, буквы «р» и прочего.

Таким образом, вы получили информацию по стоимости товаров у сайта-конкурента.

Если бы мы хотели получить что-нибудь еще, например, дополнительно еще собрать названия этих товаров, то нам нужно было бы зайти снова в Configuration > Custom > Extraction. И выбрать после этого еще один XPath-запрос и указать, например, что мы хотим собрать тег <h1>.

Просто запустив еще раз процесс, мы собираем уже не только стоимость, но и названия товаров.

В результате получаем такую связку: URL товара, его стоимость и название этого товара.

Если мы хотим получить описание или что-то еще — продолжаем в том же духе.

Важный момент: h1 собрать легко. Это стандартный элемент html и для его парсинга можно использовать стандартный XPath-запрос (посмотрите в справке). В случае же с описанием или другими элементами нам нужно всегда возвращаться в код страницы и смотреть: как называется сам тег, какой у него класс/id либо какие-то другие атрибуты, к которым мы можем обратиться с помощью XPath-запроса.

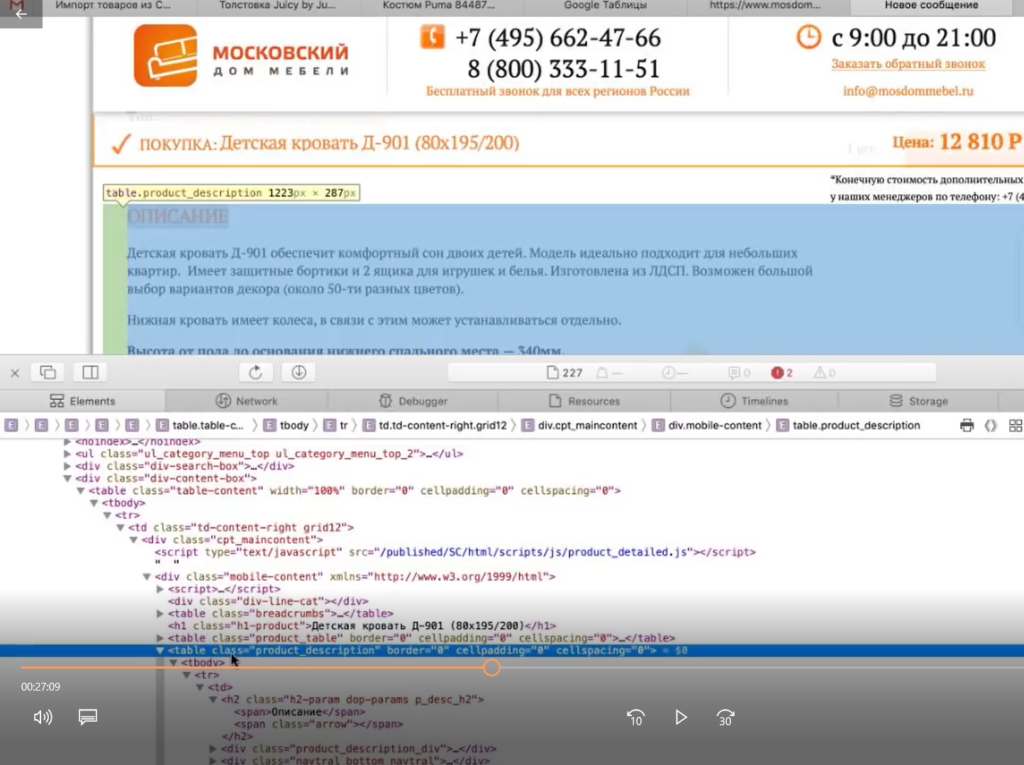

Например, мы хотим собрать описание. Нужно снова идти в Inspect Element.

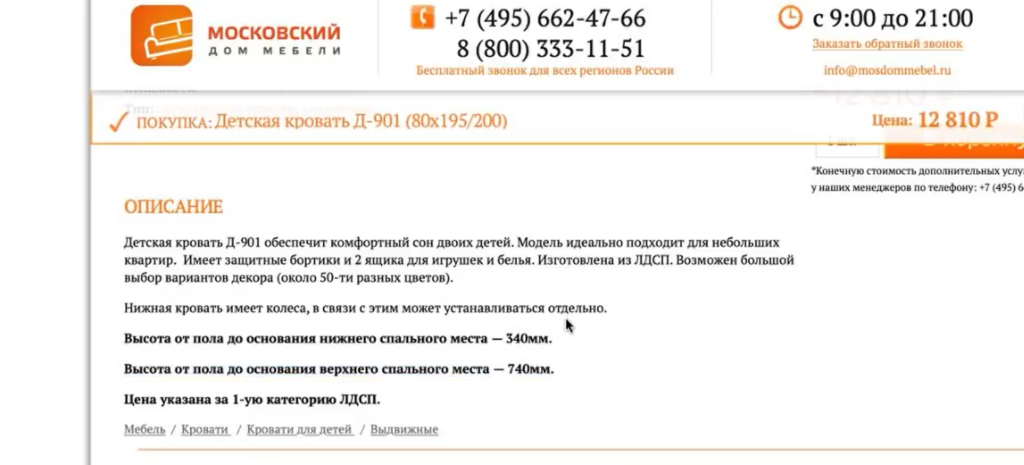

Оказывается, все описание товара лежит в теге <table> с классом product_description. Если мы его соберем, то у нас в таблицу выгрузится полное описание.

Здесь есть нюанс. Текст описания сделан с разметкой. Например, здесь есть переносы на новую строчку, что-то выделяется жирным.

Если вам нужно спарсить текст описания с уже готовой разметкой, то в настройках Extraction в парсере мы можем выбрать парсинг с html.

Если вы не хотите собирать весь html-код (потому что он может содержать какие-то классы, которые к вашему проекту никакого отношения не имеют), а нужен текст в чистом виде, выбираем только текст. Но помните, что тогда переносы строк и все остальное придется заполнять вручную.

Собрав все необходимые элементы и прогнав по ним парсинг, вы получите таблицу с исчерпывающей информацией по товарам у конкурента.

Такой парсинг можно запускать регулярно (например, раз в неделю) для отслеживания цен конкурентов. И сравнивать, у кого что стоит дороже/дешевле.

Пример 2. Как спарсить фотографии

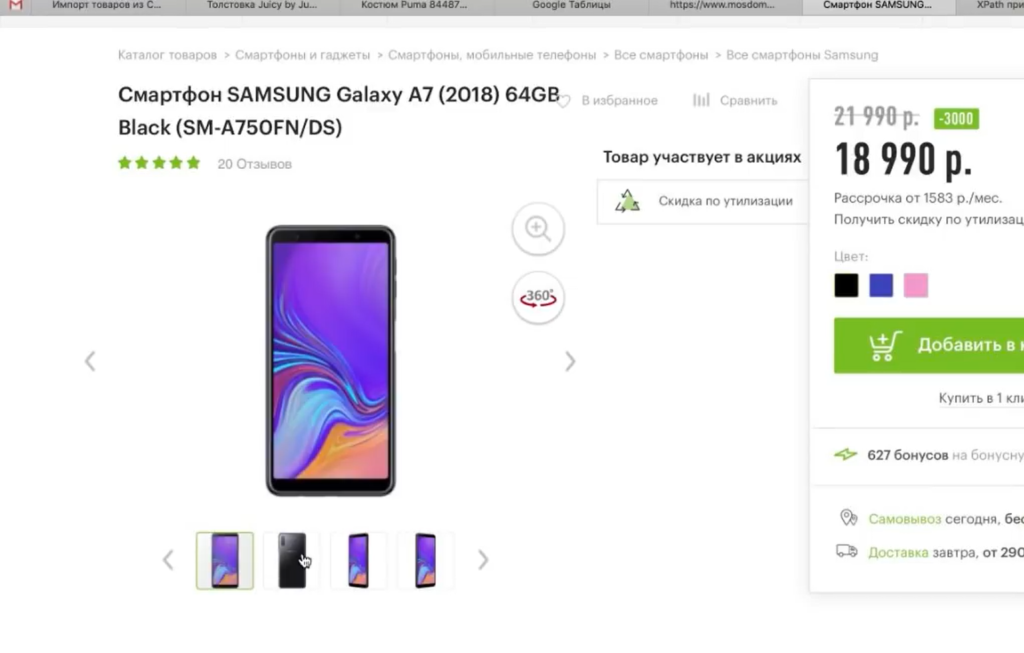

Рассмотрим вариант решения другой прикладной задачи — сбора фотографий.

На сайте Эльдорадо у каждого товара есть довольно-таки немало фотографий. Предположим, вы их хотите взять — это универсальные фото от производителя, которые можно использовать для демонстрации на своем ресурсе.

Задача: собрать в Excel адреса всех картинок, которые есть у разных карточек товара. Не в виде файлов, а в виде ссылок. Потом вы сможете их скачать либо напрямую загрузить на свой сайт. Большинство движков интернет-магазинов, таких как Битрикс и Shop-Script, поддерживают загрузку фотографий по URL. Если вы в CSV-файле, который используете для импорта-экспорта, укажете ссылки на фотографии, то по ним движок сможет загрузить эти фотографии.

Ищем свойства картинок

Для начала нам нужно понять, где указаны свойства, адрес фотографии на каждой карточке товара.

Нажимаем правой клавишей на фотографию, выбираем Inspect Element, начинаем исследовать.

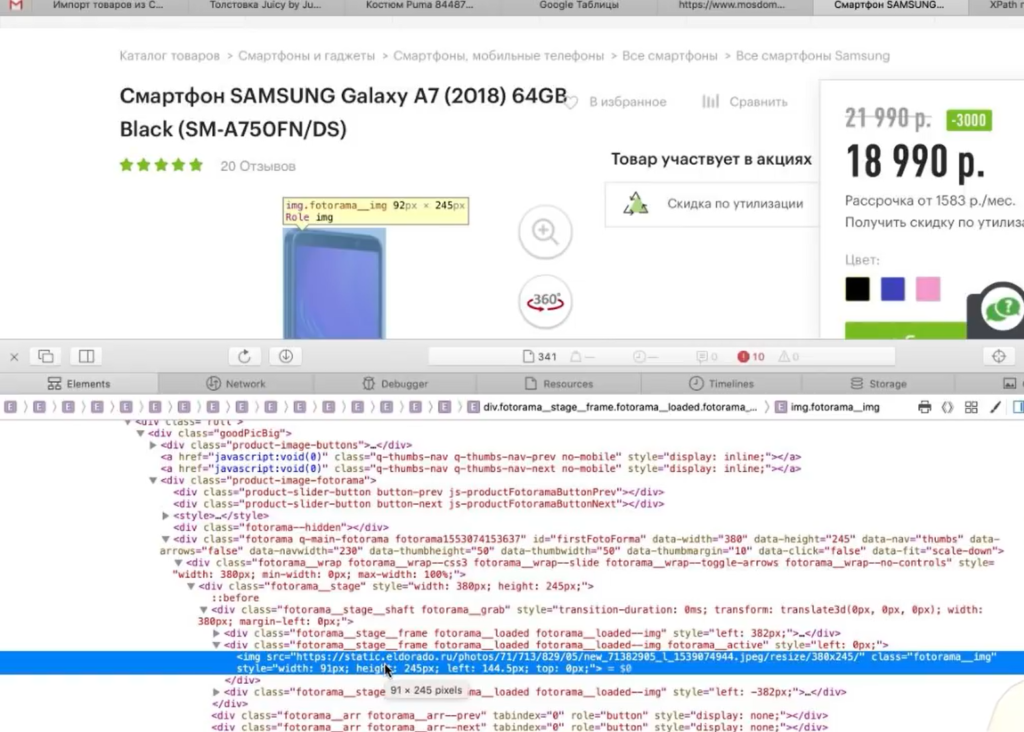

Смотрим, в каком элементе и с каким классом у нас находится данное изображение, что оно из себя представляет, какой у него URL и т. д.

Изображения лежат в элементе <span>, у которого id — firstFotoForma. Чтобы спарсить нужные нам картинки, понадобится вот такой XPath-запрос:

//*[@id="firstFotoForma"]/*/img/@src

У нас здесь обращение к элементам с идентификатором firstFotoForma, дальше есть какие-то вложенные элементы (поэтому прописана звездочка), дальше тег img, из которого нужно получить содержимое атрибута src. То есть строку, в которой и прописан URL-адрес фотографии. Попробуем это сделать.

Берем XPath-запрос, переходим в Configuration > Custom > Extraction, вставляем и жмем ОК.

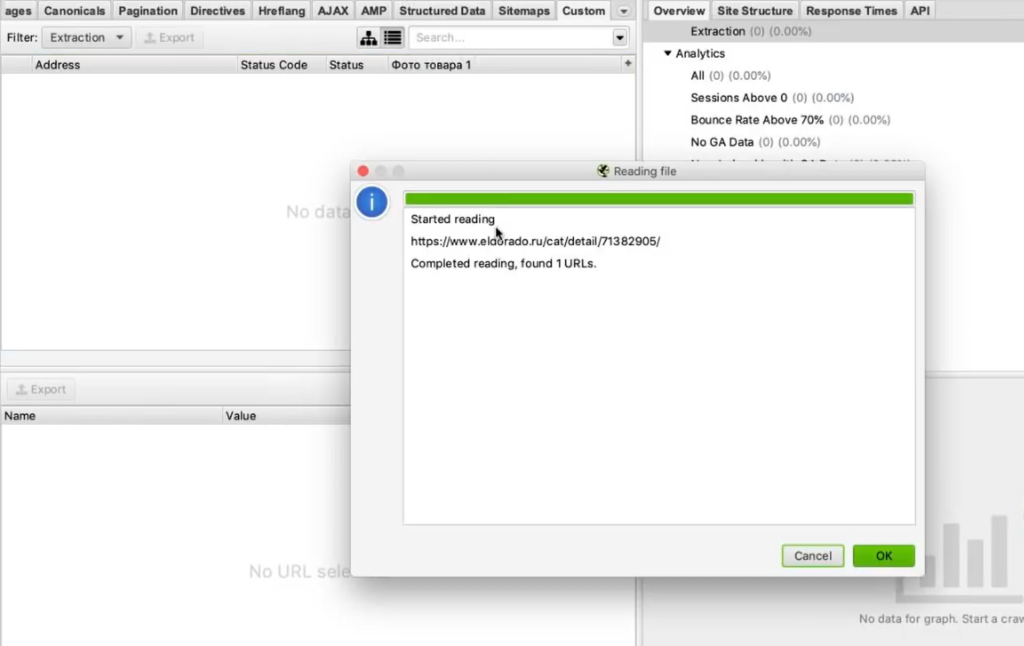

Для начала попробуем спарсить одну карточку. Нужно скопировать ее адрес и добавить в Screaming Frog таким образом: Upload > Paste.

Нажимаем ОК. У нас начинается процесс сбора информации.

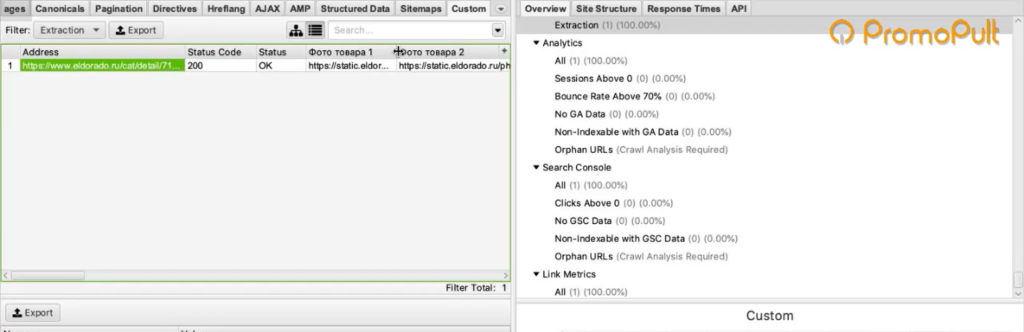

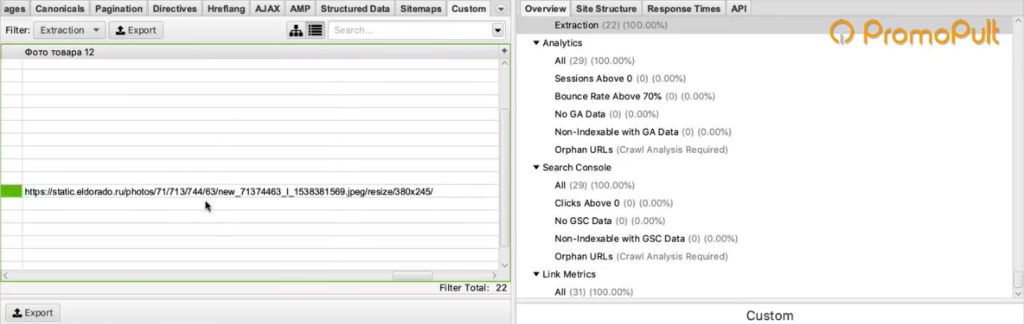

Screaming Frog спарсил одну карточку товара и у нас получилась такая табличка. Рассмотрим ее подробнее.

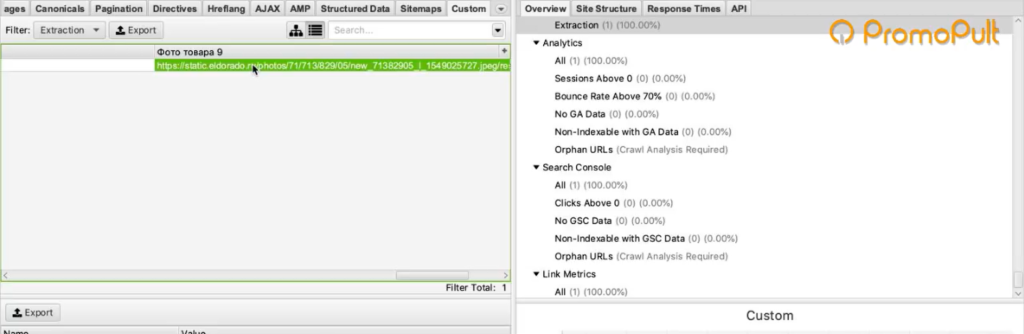

Мы загрузили один URL на входе, и у нас автоматически появилось сразу много столбцов «фото товара». Мы видим, что по этому товару собралось 9 фотографий.

Для проверки попробуем открыть одну из фотографий. Копируем адрес фотографии и вставляем в адресной строке браузера.

Фотография открылась, значит парсер сработал корректно и вытянул нужную нам информацию.

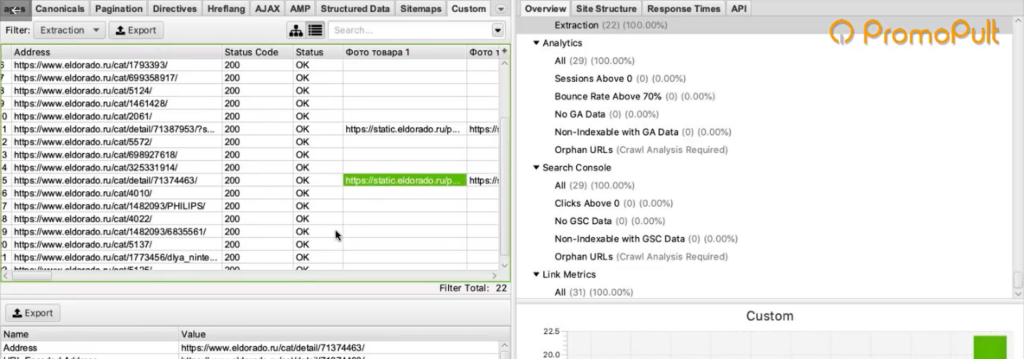

Теперь пройдемся по всему ресурсу в режиме Spider (для переключения в этот режим нужно нажать Mode > Spider). Укажем адрес https://www.eldorado.ru и нажимаем старт.

Так как программа парсит весь проект, то по страницам, которые не являются карточками товара, ничего не находится.

А с карточек товаров собираются ссылки на все фотографии.

Таким образом мы сможем собрать их и положить в Excel-таблицу, где будут указаны url-адреса всех фотографий для каждого товара.

Если бы мы собирали артикулы, то еще раз зашли бы в Configuration > Custom > Extraction и добавили бы еще два XPath-запроса: для сбора артикулов, а также тегов h1, чтобы собрать еще названия. Так мы бы убили сразу двух зайцев и собрали бы связку: название товара + артикул + фото.

Как снимать позиции сайта и парсить выдачу без лишней рутины

Пример 3. Как спарсить характеристики товаров

Следующий пример — ситуация, когда нам нужно насытить карточки товаров характеристиками. Представьте, что вы продаете книги. Для каждой у вас указано мало характеристик — всего лишь год выпуска и автор. А у Озона (сильный конкурент) — характеристик много.

Вы хотите собрать в Excel все эти данные с Озона и использовать их для своего магазина. Это техническая информация, вопросов с авторским правом нет.

Изучаем характеристики

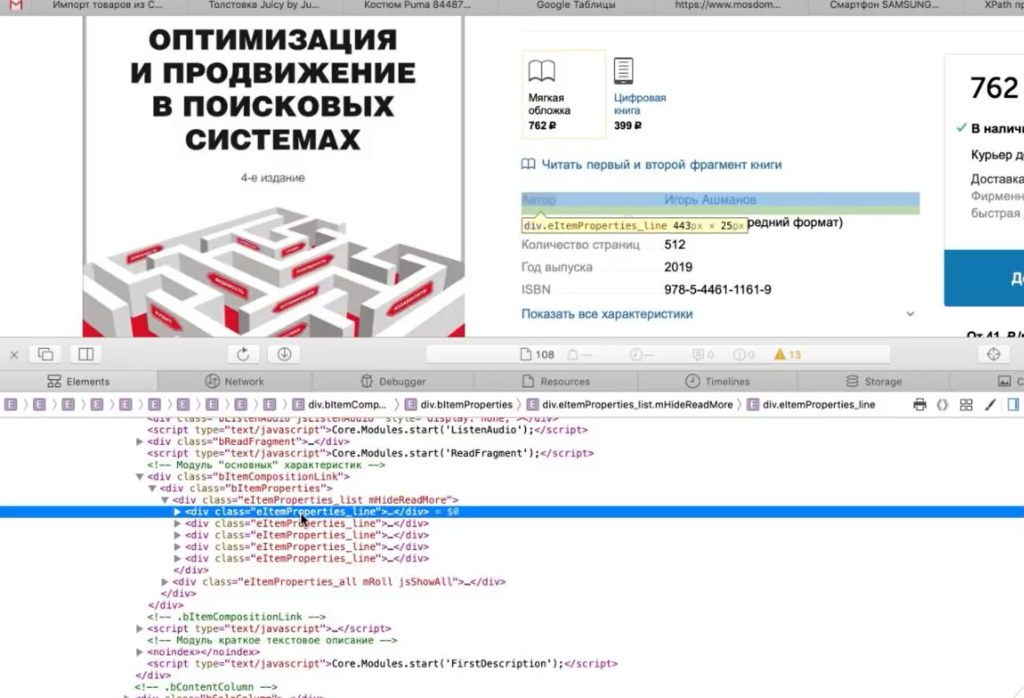

Нажимаете правой кнопкой по характеристике, выбираете Inspect Element и смотрите, как называется элемент, который содержит каждую характеристику.

У нас это элемент <div>, у которого в качестве класса указана строка eItemProperties_Line.

И дальше внутри каждого такого элемента <div> содержится название характеристики и ее значение.

Значит нам нужно собирать элементы <div> с классом eItemProperties_Line.

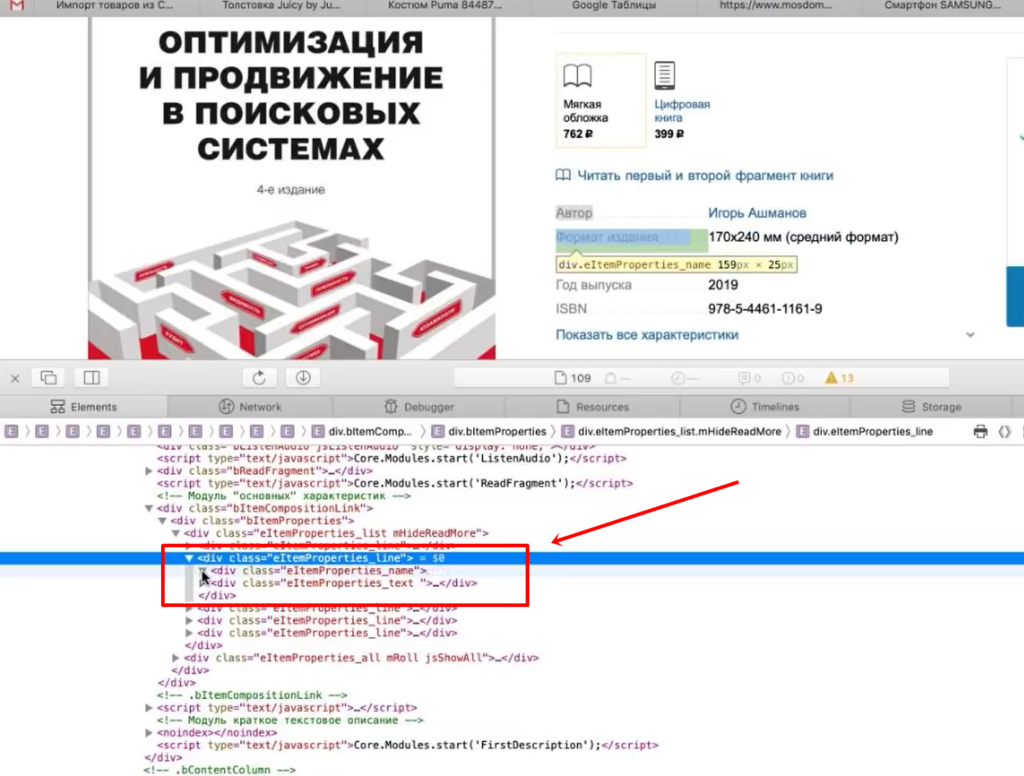

Для парсинга нам понадобится вот такой XPath-запрос:

//*[@class="eItemProperties_line"]

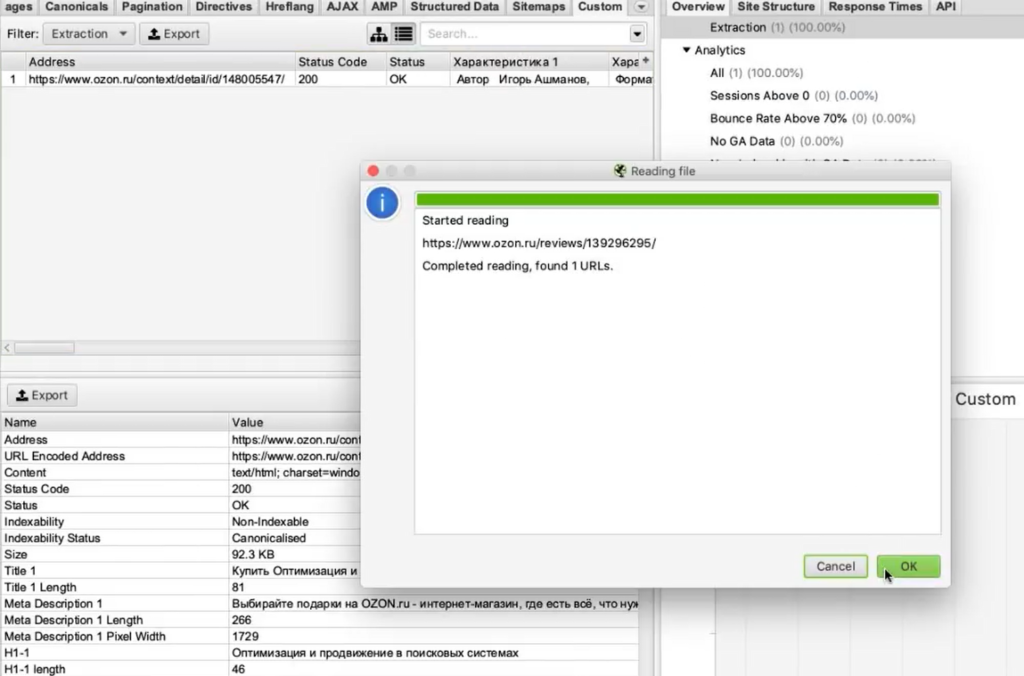

Идем в Screaming Frog, Configuration > Custom > Extraction. Вставляем XPath-запрос, выбираем Extract Text (так как нам нужен только текст в чистом виде, без разметки), нажимаем ОК.

Переключаемся в режим Mode > List. Нажимаем Upload, указываем адрес страницы, с которой будем собирать характеристики, нажимаем ОК.

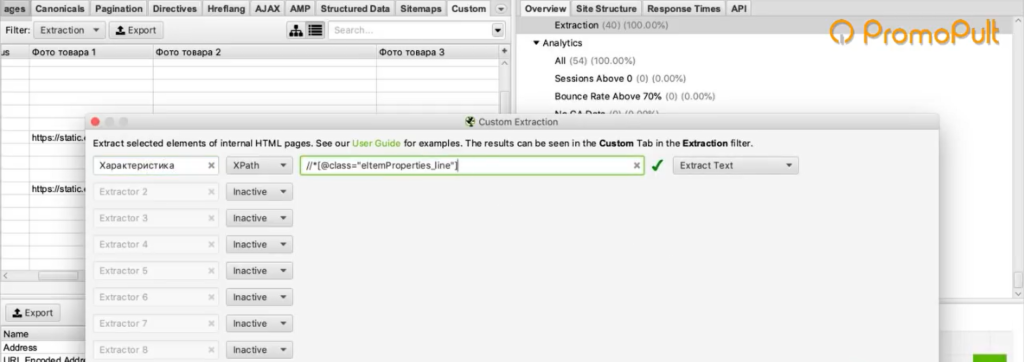

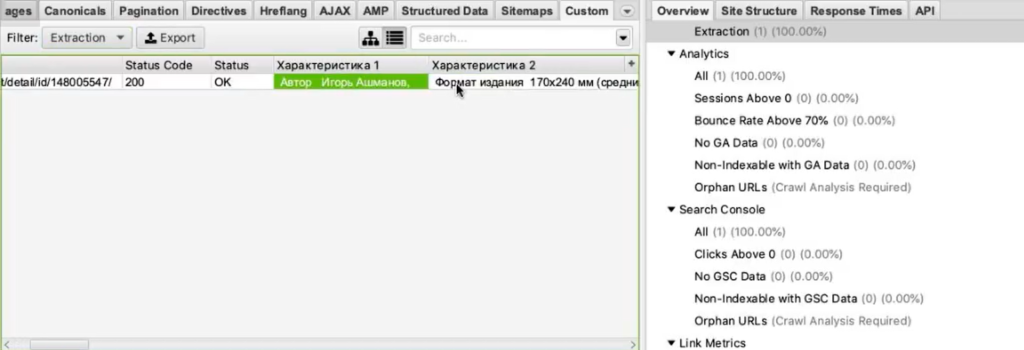

После завершения переключаемся на вкладку Custom, в списке фильтров выбираем Extraction.

И видим — парсер собрал нам все характеристики. В каждой ячейке находится название характеристики (например, «Автор») и ее значение («Игорь Ашманов»).

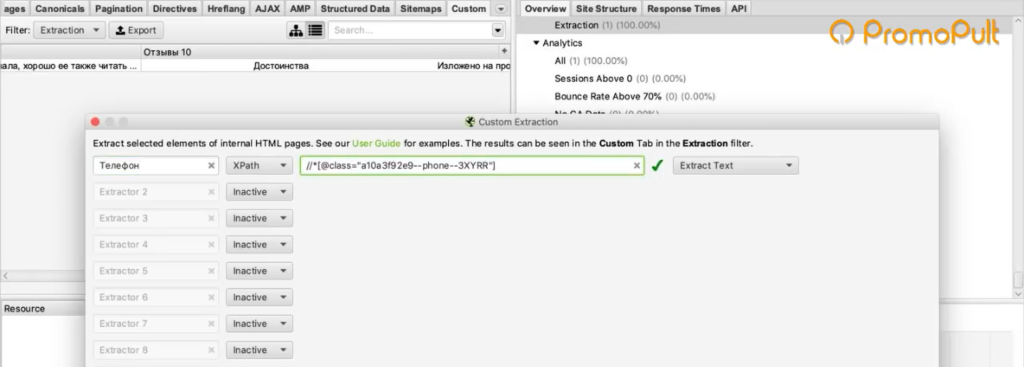

Пример 4. Как парсить отзывы (с рендерингом)

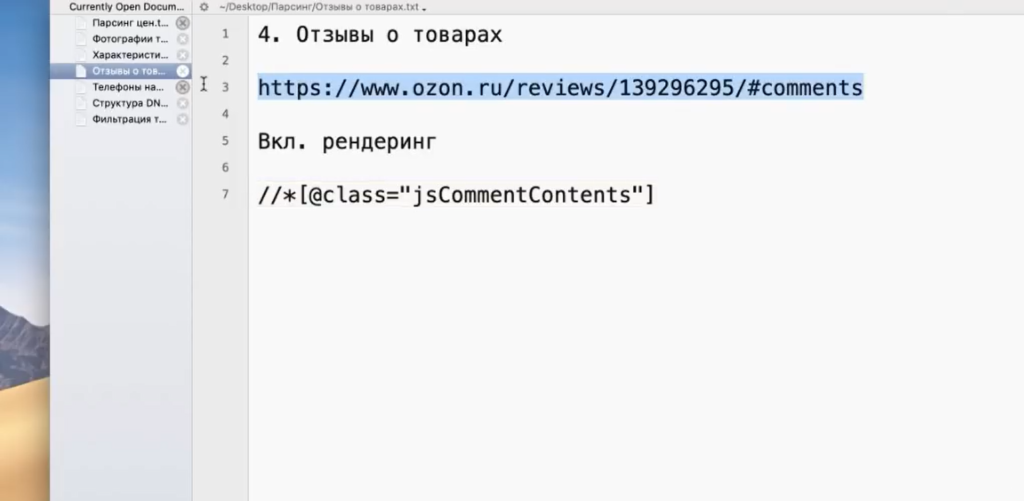

Следующий пример немного нестандартен — на грани «серого» SEO. Это сбор отзывов с того же Ozon. Допустим, мы хотим собрать и перенести на свой ресурс тексты отзывов ко всем книгам.

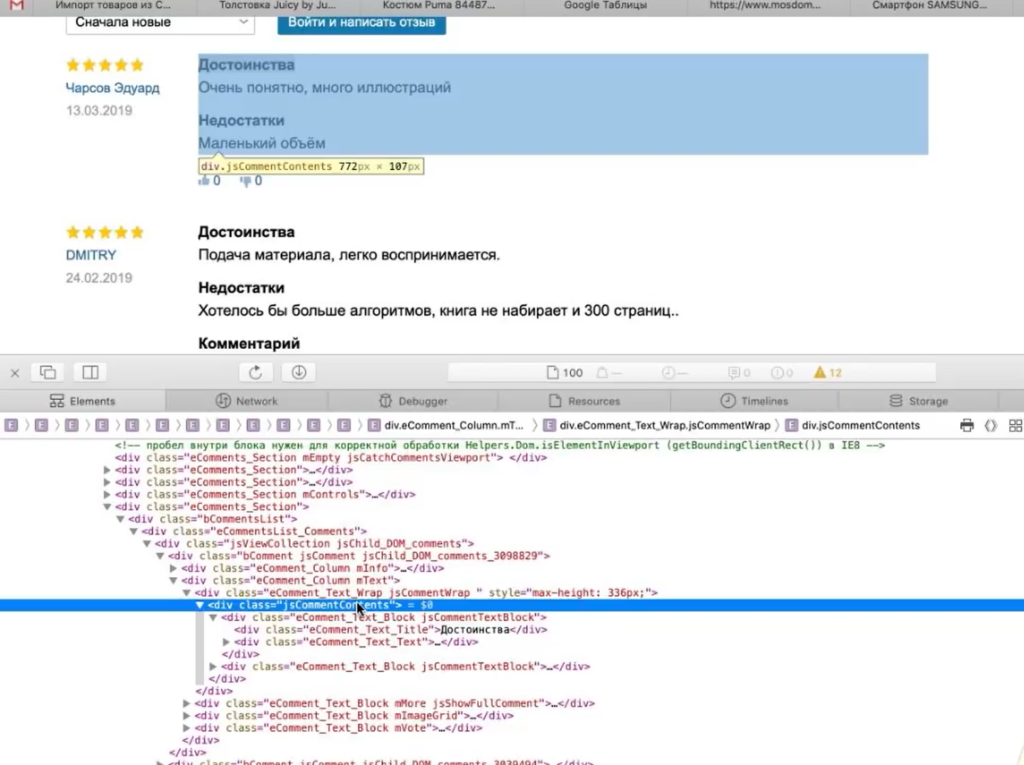

Покажем процесс на примере одного URL. Начнем с того, что посмотрим, где находятся отзывы.

Они находятся в элементе <div> с классом jsCommentContent:

Следовательно, нам нужен такой XPath-запрос:

//*[@class="jsCommentContents"]

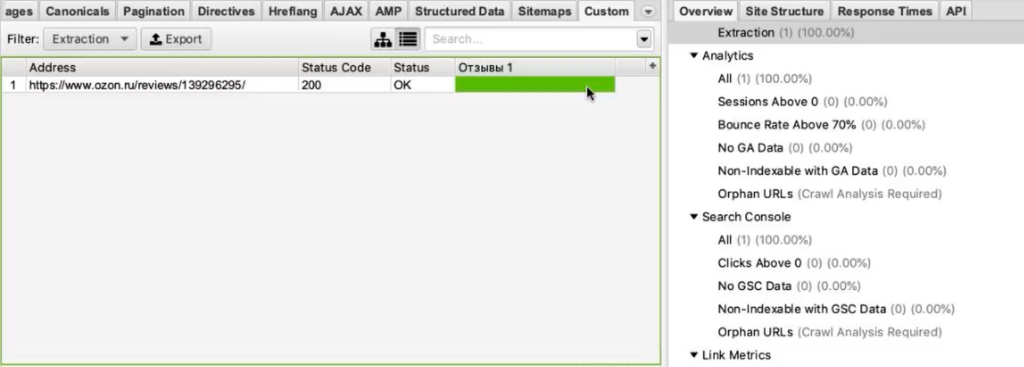

Добавляем его в Screaming Frog. Теперь копируем адрес страницы, которую будем анализировать, и загружаем в парсер.

Жмем ОК и видим, что никакие отзывы у нас не загрузились:

Почему так? Разработчики Озона сделали так, что текст отзывов грузится в момент, когда вы докручиваете до места, где отзывы появляются (чтобы не перегружать страницу). То есть они изначально в HTML нигде не видны.

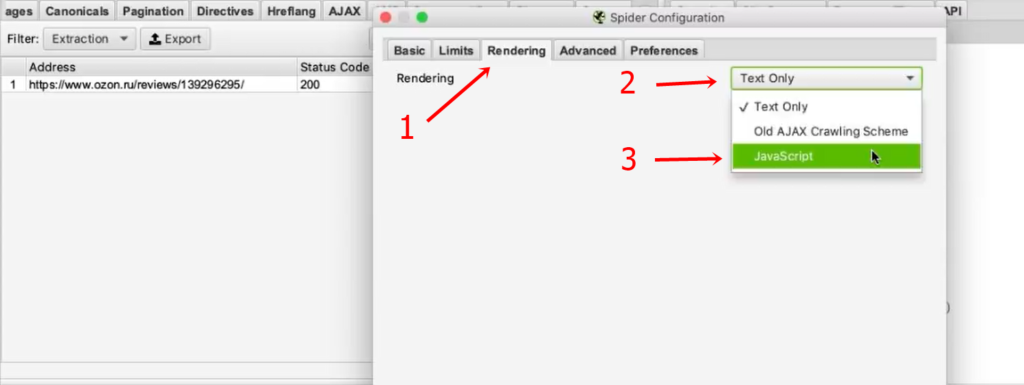

Чтобы с этим справиться, нам нужно зайти в Configuration > Spider, переключиться на вкладку Rendering и выбрать JavaScript. Так при обходе страниц парсером будет срабатывать JavaScript и страница будет отрисовываться полностью — так, как пользователь увидел бы ее в браузере. Программа также будет делать скриншот отрисованной страницы.

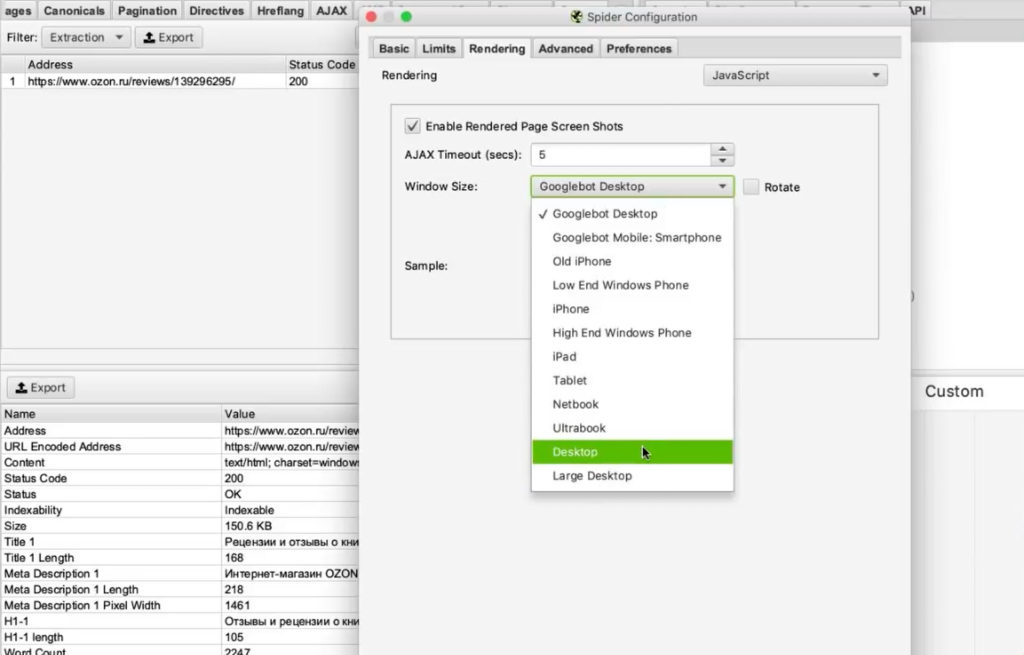

Мы выбираем устройство, с которого мы якобы заходим на сайт (десктоп). Настраиваем время задержки перед тем, как будет делаться скриншот, — одну секунду.

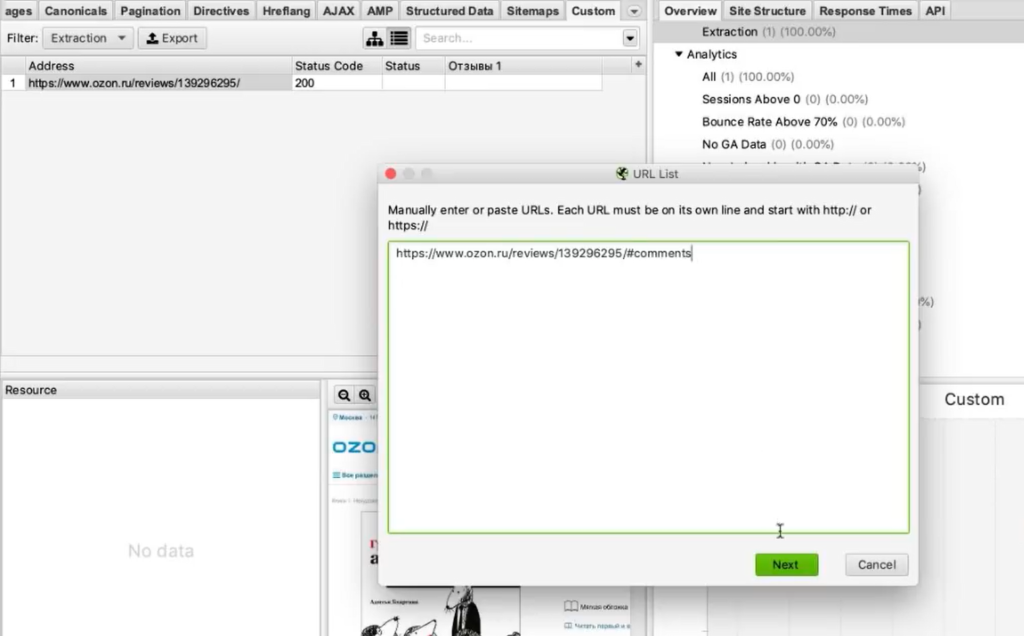

Нажимаем ОК. Введем вручную адрес страницы, включая #comments (якорная ссылка на раздел страницы, где отображаются отзывы).

Для этого жмем Upload > Enter Manually и вводим адрес:

Обратите внимание! При рендеринге (особенно, если страниц много) парсер может работать очень долго.

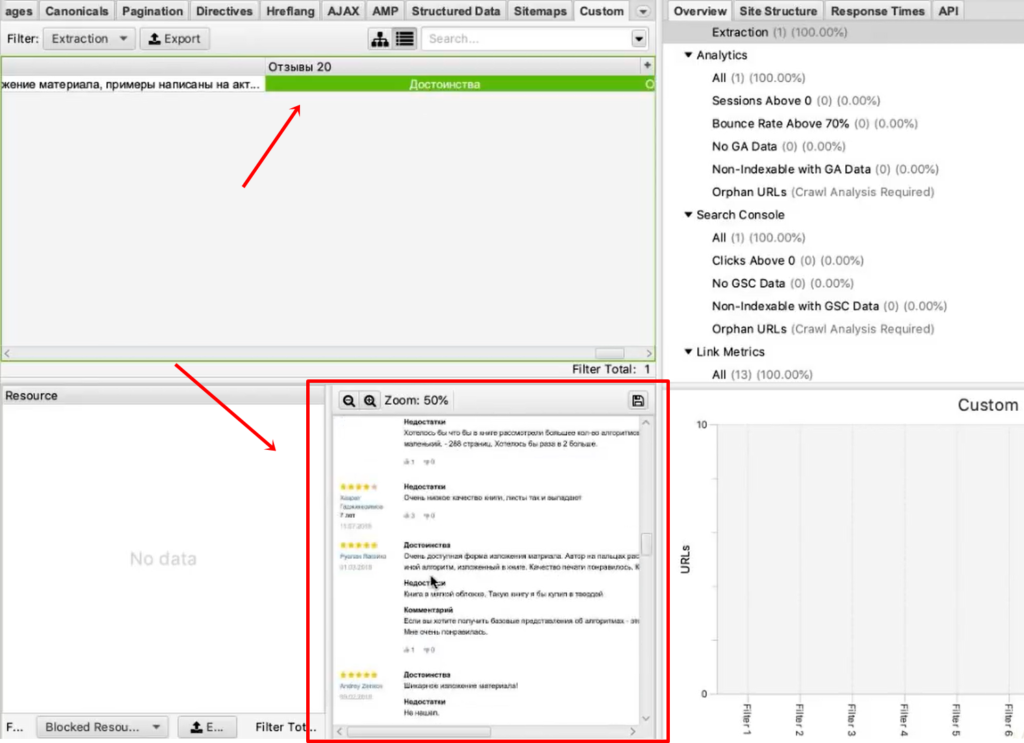

Итак, парсер собрал 20 отзывов. Внизу они показываются в качестве отрисованной страницы. А вверху в табличном варианте мы видим текст этих отзывов.

Пример 5. Как спарсить скрытые телефоны на сайте ЦИАН

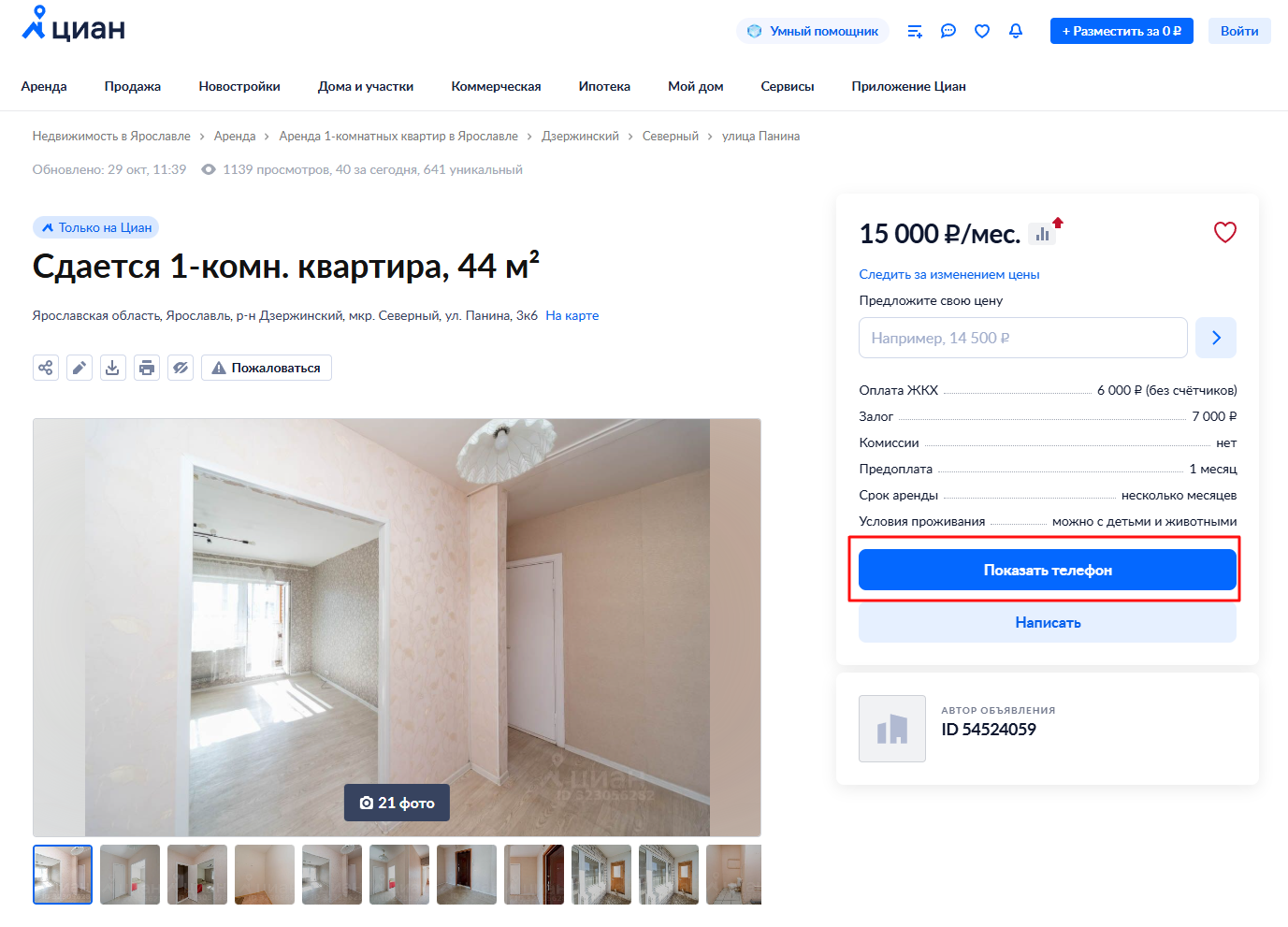

Следующий пример — сбор телефонов с cian.ru. Здесь есть предложения о продаже квартир. Допустим, стоит задача собрать телефоны с каких-то предложений или вообще со всех.

У этой задачи есть особенности. На странице объявления телефон скрыт кнопкой «Показать телефон».

После клика он виден. А до этого была видна только сама кнопка.

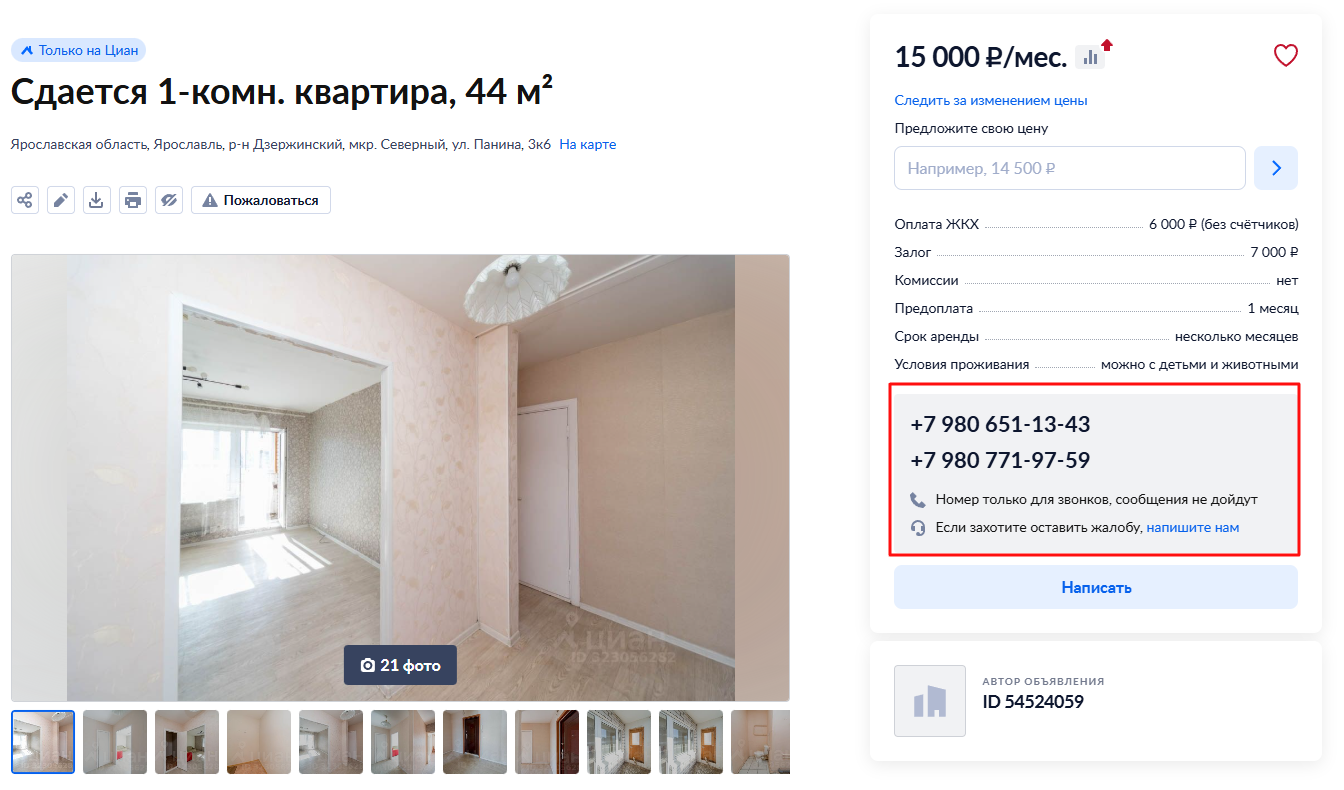

Но на сайте есть недоработка, которой мы воспользуемся. После нажатия на кнопку «Показать телефон» мы видим, что он начинается «+7 980…». Теперь обновим страницу, как будто мы не нажимали кнопку, посмотрим исходный код страницы и поищем в нем «980».

И вот, мы видим, что телефон уже есть. Он находится у ссылки, с классом a10a3f92e9—phone—3XYRR. Чтобы собрать все телефоны, нам нужно спарсить содержимое всех элементов с таким классом.

Используем этот класс в XPath-запросе:

//*[@class="a10a3f92e9—phone—3XYRR"]

Идем в Seo Spider, Custom > Extraction. Указываем XPath-запрос и даем название колонке, в которую будут собираться телефоны:

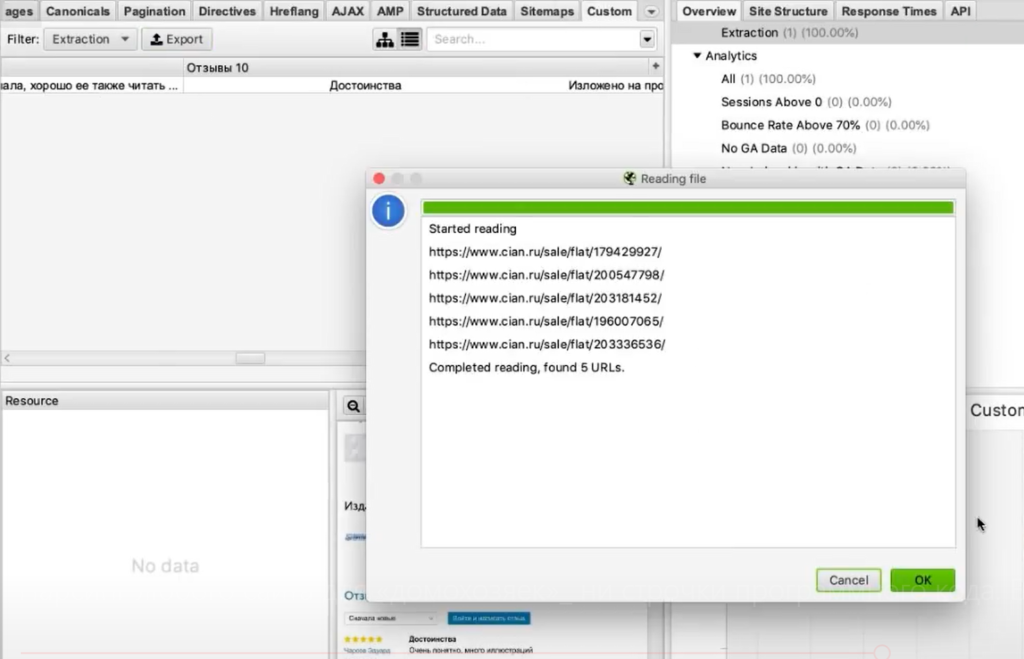

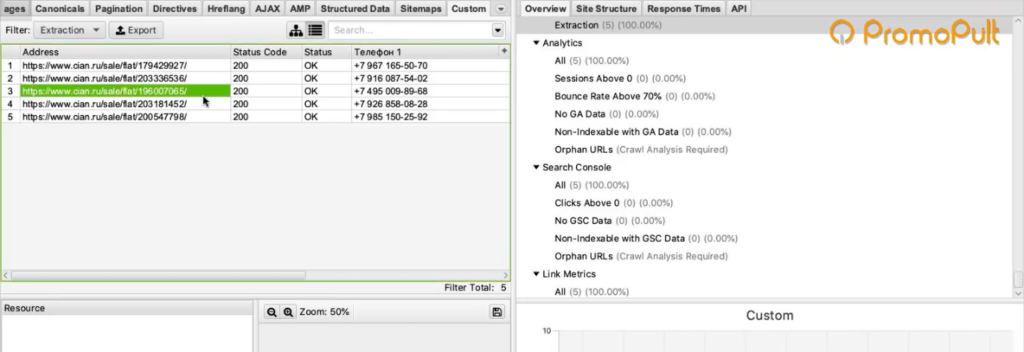

Берем список ссылок (для примера мы отобрали несколько ссылок на страницы объявлений) и добавляем их в парсер.

В итоге мы видим связку: адрес страницы — номер телефона.

Также мы можем собрать в дополнение к телефонам еще что-то. Например, этаж.

Алгоритм такой же:

- Кликаем по этажу, Inspect Element.

- Смотрим, где расположена информация об этажах и как обозначается.

- Используем класс или идентификатор этого элемента в XPath-запросе.

- Добавляем запрос и список страниц, запускаем парсер и собираем информацию.

Пример 6. Как парсить структуру сайта на примере DNS-Shop

С помощью парсинга можно собрать структуру какого-то большого каталога или интернет-магазина.

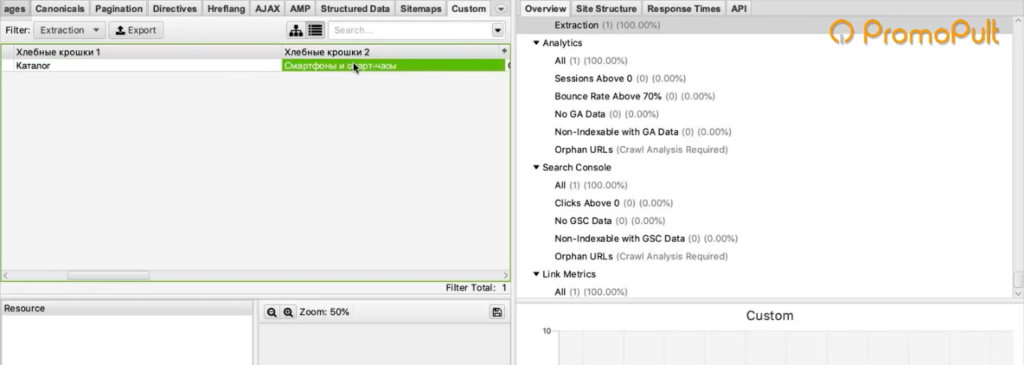

Рассмотрим, как собрать структуру dns-shop.ru. Для этого нам нужно понять, как строятся хлебные крошки.

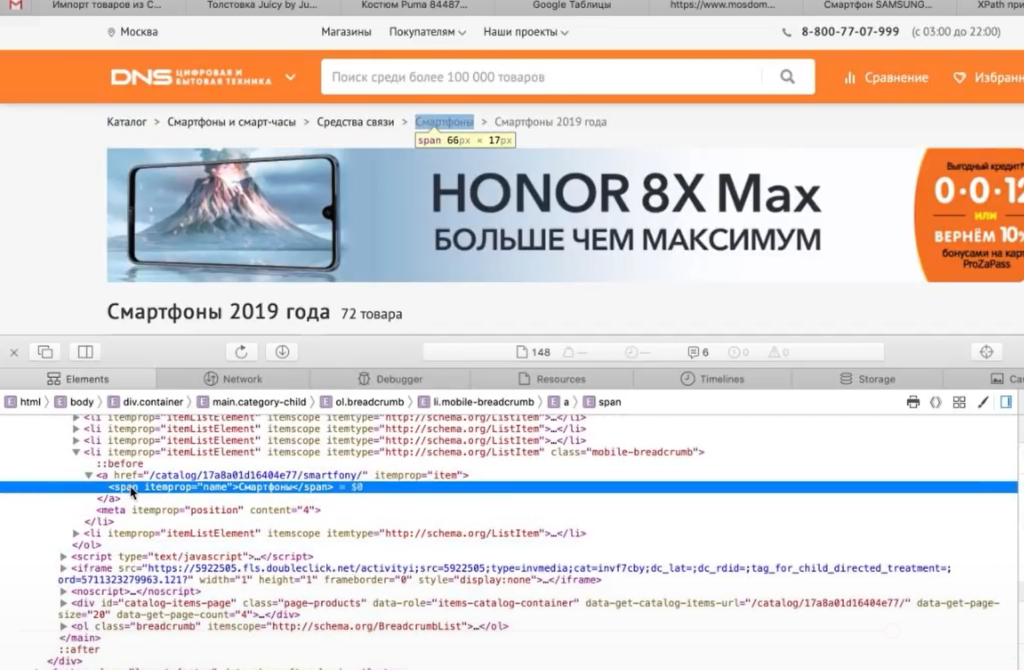

Нажимаем на любую ссылку в хлебных крошках, выбираем Inspect Element.

Она находится в элементе <span>, у которого атрибут itemprop (атрибут микроразметки) использует значение «name».

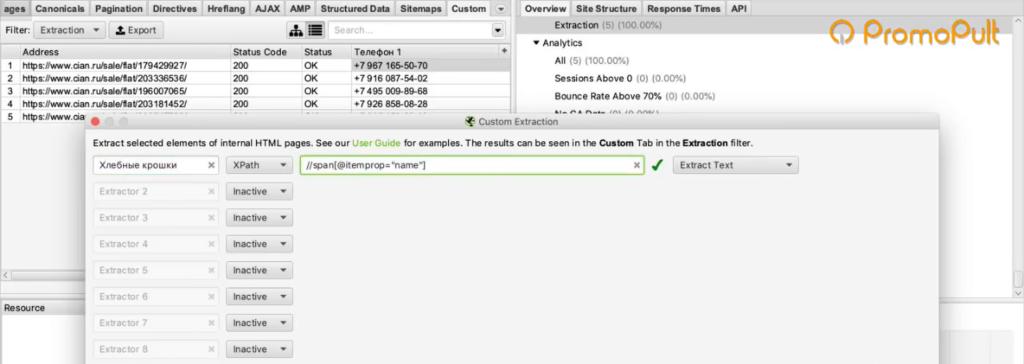

Используем элемент span со значением микроразметки в XPath-запросе:

//span[@itemprop="name"]

Указываем XPath-запрос в парсере:

Пробуем спарсить одну страницу и получаем результат:

Таким образом мы можем пройтись по всем страницам и собрать полную структуру.

Возможности парсинга на основе XPath

Что можно спарсить:

1. Любую информацию с почти любого сайта.

Нужно понимать, что есть сайты с защитой от парсинга. Например, если вы захотите спарсить любой проект Яндекса — у вас ничего не получится. Авито — тоже довольно-таки сложно. Но большинство сайтов можно спарсить.

2. Цены, наличие товаров, любые характеристики, фото, 3D-фото.

3. Описание, отзывы, структуру проекта.

4. Контакты, неочевидные свойства и т. д.

Любой элемент на странице можно вытянуть в Excel.

Ограничения при парсинге

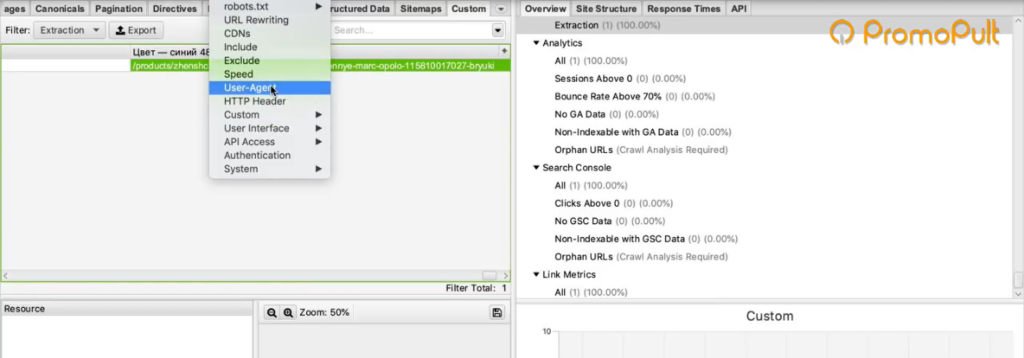

Бан по user-agent

При обращении к сайту парсер отсылает запрос user-agent, в котором сообщает информацию о себе. Некоторые ресурсы сразу блокируют доступ парсеров, которые в user-agent представляются как приложения. Это ограничение можно легко обойти. Нужно зайти в Configuration > User-Agent и выбрать YandexBot или Googlebot.

Подмена юзер-агента вполне себе решает данное ограничение. К большинству сайтов мы получим доступ таким образом.

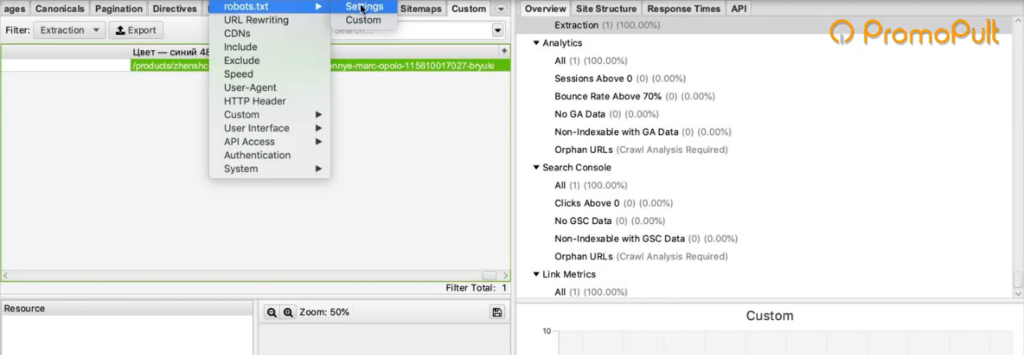

Запрет в robots.txt

Например, в robots.txt может быть прописан запрет индексирования каких-то разделов для Google-бота. Если мы user-agent настроили как Googlebot, то спарсить информацию с этого раздела не сможем.

Чтобы обойти ограничение, заходим в Configuration > Robots.txt > Settings

И выбираем игнорировать robots.txt

Бан по IP

Если вы долгое время парсите какой-то проект, то вас могут заблокировать на определенное или неопределенное время. Здесь два варианта решения: использовать решения по маскировке трафика или в настройках парсера снизить скорость, чтобы не делать лишнюю нагрузку на сайт и уменьшить вероятность бана.

Анализатор активности или капча

Некоторые ресурсы защищаются от парсеров с помощью умного анализатора активности. Если ваши действия похожи на роботизированные (когда обращаетесь к странице, у вас нет курсора, который двигается, или браузер не похож на стандартный), анализатор показывает капчу, которую парсер не может обойти. Такое ограничение можно обойти, но это долго и дорого.

Теперь вы знаете, как собрать любую нужную информацию с сайтов конкурентов. Пользуйтесь приведенными примерами и помните — почти все можно спарсить. А если нельзя — то, возможно, вы просто не знаете как.

Полный автопилот с указанием домена и бюджета или тонкая ручная настройка:

Запустить рекламу в PromoPult