Анализ семантики, видимости и трафика сайтов-конкурентов

Хочешь попасть в топ — приглядись к сайтам, которые уже там. Вручную кликать на ссылки неэффективно и крайне трудозатратно. Верный путь — собрать семантическое ядро лидеров выдачи и посмотреть, по каким запросам конкуренты получают трафик.

О том, как и зачем анализировать семантику и трафик конкурентов и как делать это эффективно, рассказал Евгений Костин.

Видео смотрите на канале Обучающего центра CyberMarketing:

Зачем нужен анализ конкурентов

Самая очевидная причина: аналитика конкурентов на выдаче нужна для того, чтобы успешнее продвигать свой ресурс. Раскроем эту мысль подробнее:

- Найти лидеров и аутсайдеров в тематике. Достоверно принципы работы поисковых алгоритмов не знает ни один SEO-специалист, поэтому точно нельзя сказать, каким моментам в оптимизации сайта нужно уделить больше внимания, а какие влияют на ранжирование незначительно. Но можно зайти с другой стороны — оценить результат, а именно уже отранжированные сайты, и попытаться определить, какие факторы повлияли на их позиции в топе.

- Собрать семантику конкурентов. Чем обширнее семантическое ядро, тем больше потенциальных возможностей для получения трафика из поиска. Возможно, ваши конкуренты проработали группы запросов, которые вы упускаете.

- Определиться с типом посадочной страницы. Кластер запросов может вести на главную, карточку товара, статью, подборку и т. п. Анализ сайтов конкурентов подскажет, куда вести ключи, в спорных случаях. А как подготовить посадочные страницы под поисковые запросы, читайте здесь.

В целом, регулярный мониторинг конкурентов поддерживает дух соперничества, помогает выявить удачные и неудачные практики, вовремя заметить новые фишки и применить их для продвижения своего проекта.

Как можно анализировать сайты конкурентов в выдаче

Анализировать конкурентов в SERP эффективнее всего при помощи специализированных инструментов. Можно ли пойти простым путем и вручную прокликать пару десятков ссылок? Такой способ отнимет массу времени и не принесет результата. И вот почему.

Минусы ручного анализа

Минус №1: вы увидите только верхушку айсберга — в лучшем случае, ситуацию по нескольким десяткам запросов. Все семантическое ядро (а это десятки и сотни тысяч запросов у крупных проектов) проанализировать вручную просто нереально.

Минус №2: в выборку могут попасть сайты, которые заняли топ по нескольким ключевым запросам при помощи накрутки поведенческих факторов. Мало того, что такие ресурсы часто не задерживаются в выдаче надолго, это смажет картину, ведь остальные факторы (внутренняя оптимизация, ссылочная масса, структура и прочие) у таких сайтов, как правило, не проработаны.

Минус №3: вы не видите ситуацию в динамике. Позиции сайтов меняются каждый день, в некоторых случаях — несколько раз в день. Также нельзя исключать влияние «многорукого бандита» Яндекса, который помещает в топ новые ресурсы, чтобы собрать по ним информацию о CTR, поведенческих факторах и др. Для разработки собственной стратегии важно смотреть на стабильно присутствующие в топе проекты.

Минус №4: это несерьезный подход. Вручную невозможно полноценно сравнить ситуацию в двух поисковых системах (Яндексе и Google), мобильную и десктопную выдачу, выдачу по разным регионам.

Итак, наш путь — воспользоваться автоматизированными сервисами для анализа конкурентов. Скажем несколько слов о принципах их работы.

Алгоритм работы сервисов анализа выдачи

Откуда данные о трафике, видимости, семантике сайтов в выдаче попадают в автоматизированные сервисы? Им сливают эту информацию поисковики? Оставим конспирологию и раскроем алгоритм работы инструментов аналитики:

- Сервисы собирают обширную семантику (ключевые слова с частотностью) и постоянно ее актуализируют. Период актуализации у каждого сервиса свой — это может быть раз в месяц, в режиме онлайн и т. д.

- Они регулярно мониторят топ-50/100 выдачи в Яндексе и Google по этому пулу запросов. Почти у всех сервисов есть также отдельные данные по десктопной и мобильной выдаче и по разным регионам (количество регионов может существенно различаться).

- Далее аналитики сервиса выявляют средний CTR каждой позиции выдачи, то есть процентное отношение показов сайта на определенной позиции к кликам по ссылке.

- На последнем шаге вычисляется возможный трафик на основе запросов, по которым сайт находится в выдаче, и CTR его позиций. Это вычисляется при помощи формул, которые у каждого сервиса разные.

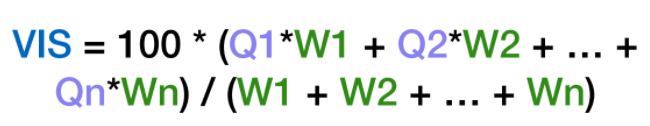

Вот пример формулы расчета процента видимости сайта (VIS) в сервисе Rush Analytics, где Q1-Qn — коэффициент видимости запроса в группе, W1-Wn — точная частотность этих запросов по Wordstat:

Как анализировать видимость конкурентов самостоятельно

Шаг первый. Соберите максимально полную семантику и постоянно ее актуализируйте.

Как бесплатно и быстро собрать семантическое ядро при помощи PromoPult, подробно описано в этом гайде.

Шаг второй. Еженедельно делайте «снимки выдачи», то есть собирайте топ-50 по каждому поисковику с разделением на мобильную/десктопную выдачу и регионы, если это актуально. Если семантика очень обширная, мониторьте группу самых частотных запросов.

Шаг третий. Стройте графики видимости за период, чтобы сравнить свой сайт с конкурентами. Полезно смотреть динамику по группам запросов. Например, выбирать только коммерческие (со словом «купить»).

Полноценно выполнить все эти шаги без привлечения автоматизированных инструментов невозможно. Перед тем, как выбирать тот или иной сервис для анализа сайтов-конкурентов, стоит проверить, насколько близки его данные к действительности. Сделать это достаточно просто. Сравните данные сервиса по сайту, к сервису веб-аналитики которого (Яндекс.Метрика, Google Аналитика) у вас есть доступ. Если данные стороннего сервиса отличаются не больше, чем на 10-20% от данных в Метрике/Аналитике, его можно использовать в качестве инструмента анализа конкурентов.

Обратите внимание на особенность сбора данных сервисами аналитики с молодых и очень больших ресурсов. Если ваш проект недавно запущен и трафик на него минимальный, сервис не сможет правильно оценить его значения (возможно существенное занижение показателей). Также можно увидеть цифры меньше реальных у масштабных сайтов с огромной семантикой и большой долей брендовых запросов.

Анализ трафика и видимости конкурентов при помощи сервиса keys.so

keys.so — платный сервис аналитики конкурентов. Базовый тариф обойдется в 4900 руб. в месяц (или 3675 руб. при оплате за год), его возможностей хватит для анализа некрупных сайтов с семантикой не больше 50 000 запросов.

Вот какие возможности для анализа трафика и видимости сайтов-конкурентов есть в keys.so.

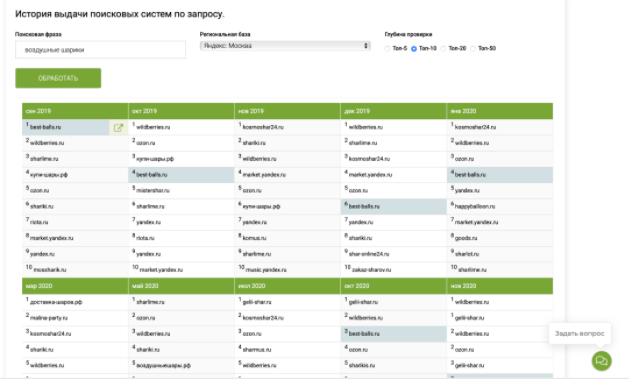

Для начала посмотрим динамику позиций сайта по определенному запросу за период в отчете «История выдачи поисковых систем по запросу».

При помощи этого отчета можно мониторить группу важных для вас запросов и анализировать, какие сайты улучшают свои позиции по ним, а какие наоборот снижаются в выдаче. Можно выбрать поисковую систему и регион. Анализ контента и оптимизации посадочных страниц, которые находятся в топе и стабильно растут, поможет в разработке стратегии для своего проекта.

В отчете могут быть сайты, которые то появляются в топе, то исчезают из выдачи вовсе или снижаются за пределы топ-20. Это может свидетельствовать об экспериментах поисковой системы либо о накрутке поведенческих факторов.

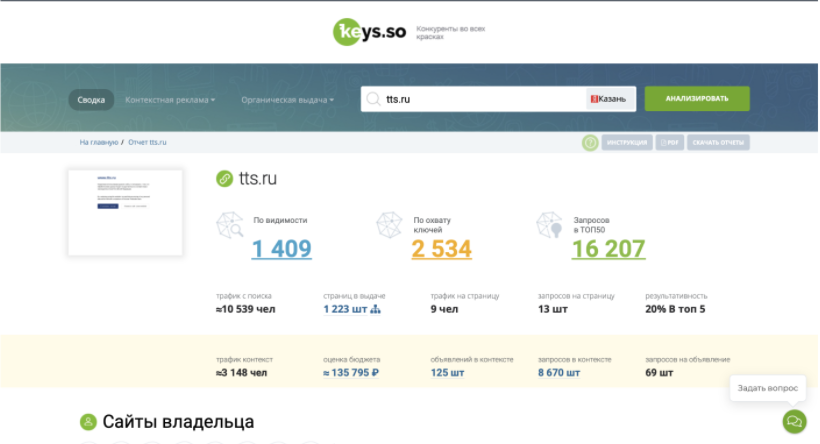

Также сервис предоставляет данные об общем трафике сайта, его видимости и позициях. Достаточно ввести домен, поисковую систему, для коммерческого сайта обязательно выбрать регион и нажать кнопку «Анализировать». Мы получим банные по видимости, охвату ключей и количеству запросов в топ-50:

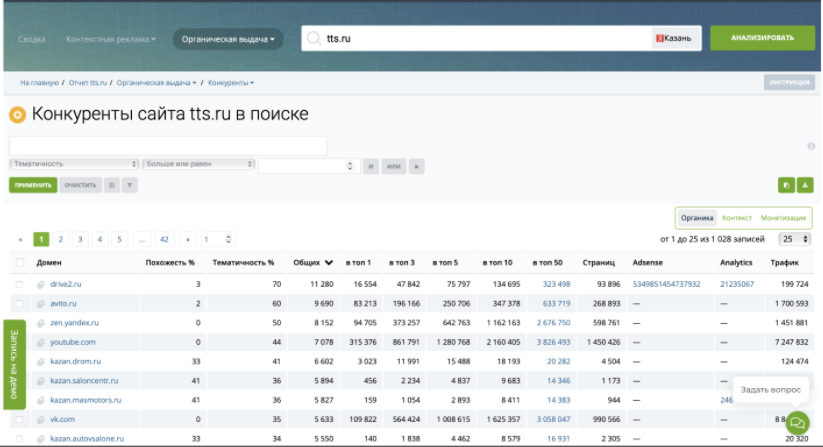

Еще одна полезная фича — экспресс-определение конкурентов. Используйте этот отчет, когда нужно быстро понять, какие сайты конкурируют с вашим в выдаче. Вы получите выборку на основе того пула семантики, по которому ранжируется ваш сайт (с учетом региона).

Таблицу конкурентов можно отсортировать по похожести, тематичности, количеству запросов в топах и другим параметрам.

Еще можно получить подробный отчет по запросам конкурента и выгрузить его в Excel. Что можно сделать с этими данными? Прежде всего, заново спарсить частотность (в сервисе она показывается с небольшой задержкой). Сделать это быстро и дешево можно парсером Wordstat в PromoPult. Подробное описание функционала инструмента — здесь. Релевантными запросами с ненулевой частотностью вполне можно дополнить семантическое ядро своего сайта.

В модуле SEO платформы PromoPult среди прочих возможностей есть и аналитика конкурентов: можно бесплатно собрать запросы сайтов-конкурентов и оценить текстовую оптимизацию их посадочных страниц.

Работа с семантикой в keys.so

Подробнее остановимся на том, какие возможности для работы с семантикой есть в сервисе keys.so.

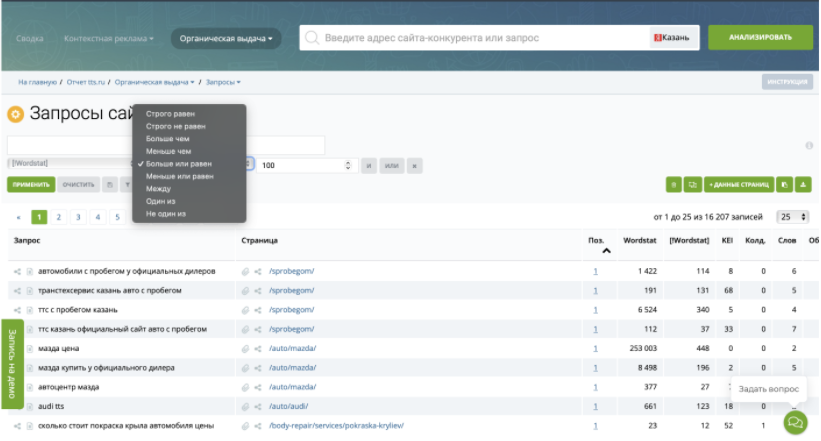

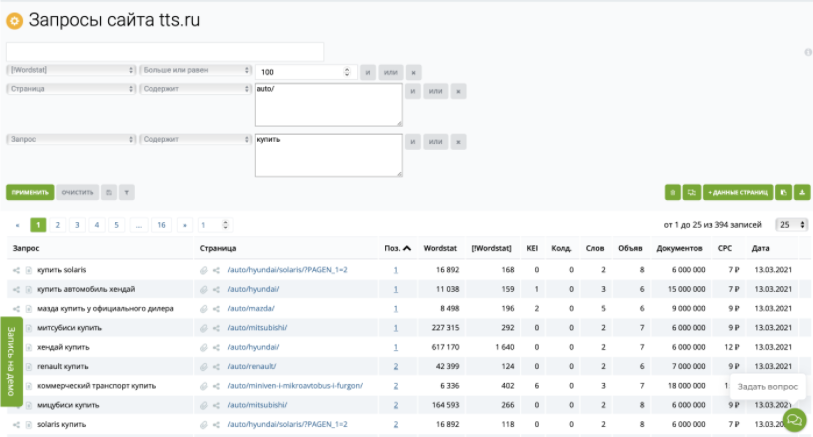

Фильтрация запросов конкурентов

Например, можно отсортировать только информационные или только коммерческие запросы, запросы с добавкой «б/у», с определенным ключом или нужной частотностью.

Кроме вычленения нужных групп семантики эта функция еще и сэкономит бюджет: она дает возможность выгружать запросы небольшими группами несколько раз, не превышая лимит минимального тарифа.

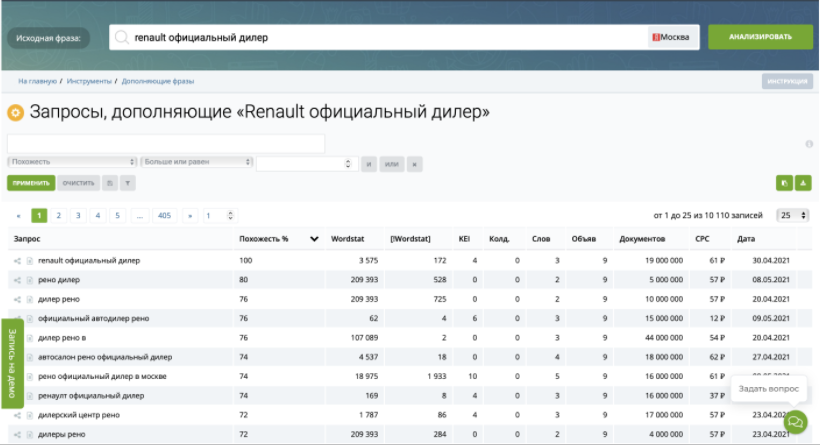

Сбор дополняющих запросов

Сервис собирает ключевые слова, по которым показываются схожие посадочные страницы. Эти запросы можно отфильтровать, выбрать релевантные и дополнить ими семантическое ядро.

В PromoPult расширить семантическое ядро можно несколькими способами: при помощи подборщика ключевых слов в модуле «Поисковое продвижение» и профессиональных инструментов — парсеров поисковых подсказок и фраз ассоциаций.

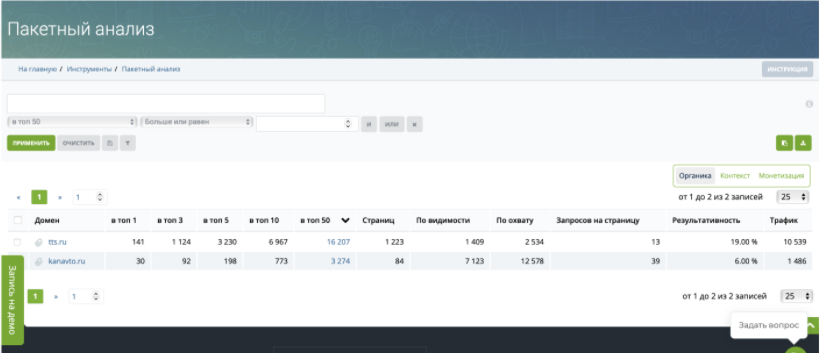

Пересекающиеся запросы по нескольким конкурентам

Отчет «Пакетный анализ» покажет ключевые слова, которые есть в семантических ядрах нескольких сайтов. Это быстрый способ проанализировать несколько конкурентов с обширной семантикой и отличиями в структуре услуг, товаров или собственно сайта. Например, один из конкурентов продает б/у автомобили, другой развивает блог и т. д., вам же нужны ключи, которые объединяют эти сайты.

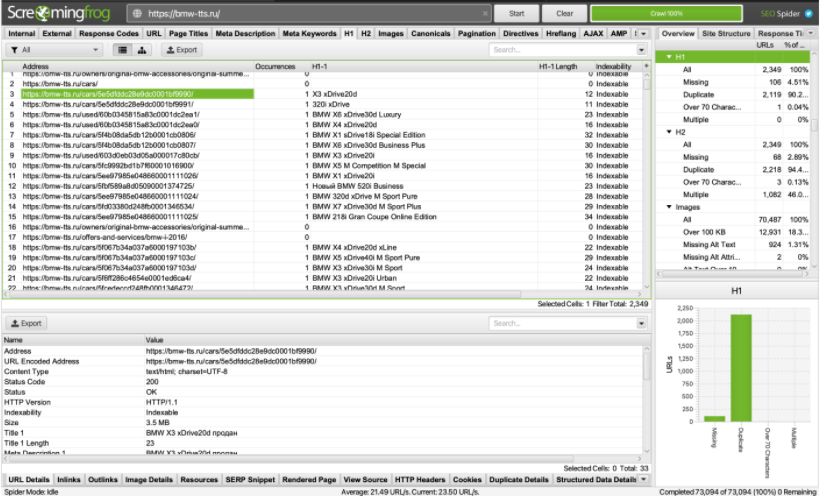

Парсинг структуры сайта-конкурента в ScreamingFrog

ScreamingFrog SEO Spider — платный анализатор сайтов. Стоимость лицензии на год — £149. Есть бесплатная версия, но ее функционал сильно ограничен.

Подробно о возможностях парсера читайте в этой статье, а здесь мы остановимся на том, как с его помощью собрать структуру сайта-конкурента.

ScreamingFrog проходит по всем ссылкам любого сайта, как это сделал бы краулер поисковой системы. В программу можно также загрузить файл Sitemap.xml.

Что это дает?

- В отчете по заголовкам h1 содержится базовая семантика ресурса, которую можно расширять и дополнять.

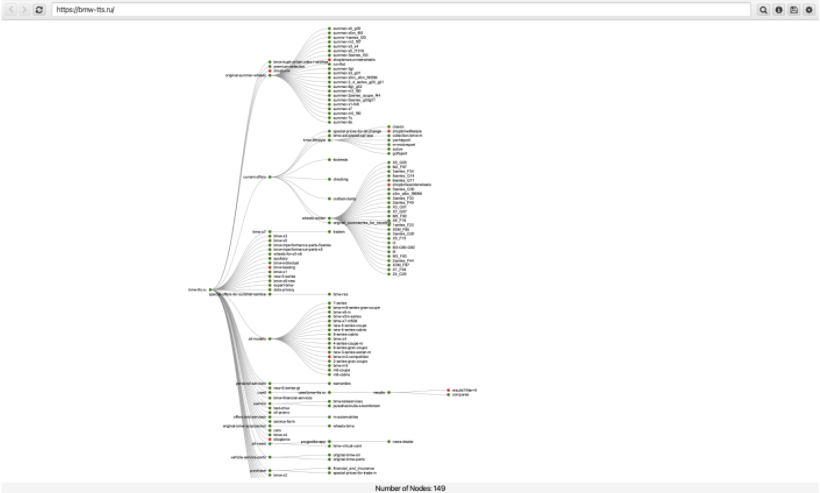

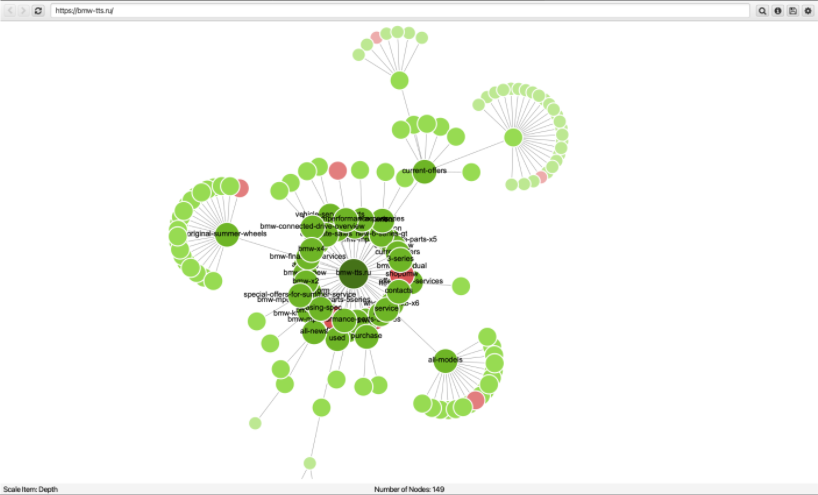

- Опираясь на заголовки h1, можно визуализировать структуру страниц. Например, таким образом:

Или так:

Такую структуру можно также импортировать в Excel и распределить по ней собранную семантику.

Коротко о главном

Автоматизированные сервисы позволяют:

- Выявить сайты в топе выдачи, на которые стоит равняться, разрабатывая SEO-стратегию для своего ресурса.

- Определить видимость сайтов-конкурентов по группе запросов, а также узнать общий трафик, позиции в динамике и другие важные сведения.

- Собрать и выгрузить семантику конкурентов, используя фильтры и тонкие настройки.

- Спарсить структуру сайта конкурента и соотнести ее с собранной семантикой.

Анализируйте конкурентов, разрабатывайте на основе собранных данных стратегию продвижения собственных проектов, а кроме упомянутых сервисов используйте в работе профессиональные инструменты PromoPult. Удачного покорения топа!

Полный автопилот с указанием домена и бюджета или тонкая ручная настройка:

Запустить рекламу в PromoPult