8 SEO-правил на этапе разработки сайта

В процессе разработки сайта важно сразу предусмотреть выполнение требований поисковых систем, чтобы в итоге получить оптимизированный ресурс. В противном случае придется дорабатывать его уже в процессе продвижения, что отнимет и время, и деньги, и замедлит рост позиций в поиске. Ниже приведено 8 SEO-правил, которых необходимо придерживаться на этапе разработки сайта.

1. Оптимизация структуры

Перед формированием ТЗ на разработку сайта у вас обязательно должно быть готовое семантическое ядро, разбитое на группы. Исходя из семантики будет проще проработать структуру ресурса.

Сначала создайте ментальную карту сайта — набросайте категории и подкатегории, которые вы считаете целесообразными. Это можно сделать и на листе бумаги, но удобнее использовать специализированные инструменты вроде Microsoft Visio.

Далее определитесь с названиями категорий и подкатегорий в соответствии с высокочастотными запросами. Установите приоритетность их расположения в меню. Старайтесь, чтобы на сайте было не более 3-4 уровней вложенности страниц. В противном случае могут возникнуть проблемы с индексацией, да и посетителям будет неудобно блуждать по длинным навигационным цепочкам.

Чтобы передавать информацию о структуре поисковикам, необходимо создать файл sitemap.xml, который помещается в корень сайта.

2. Файл robots.txt

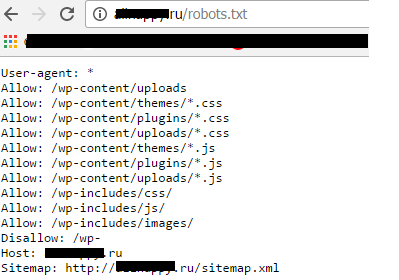

Robots.txt — это служебный файл, который создается в текстовом редакторе (блокноте) и наряду с sitemap.xml размещается в корне сайта. Здесь прописаны директивы для поисковых роботов, указывающие на файлы и папки, которые не нужно индексировать. Директивы носят рекомендательный характер. Поэтому если вы хотите наверняка скрыть от индексации конкретные страницы, то лучше использовать метатег noindex (примечание: работает только в отношении робота Яндекса, Google же его игнорирует):

<meta name="robots" content="noindex">

Также можно скрыть директории и файлы с помощью защиты каталогов сервера паролем.

Разные поисковые роботы поддерживают разные директивы. Например, для Яндекса и Google можно прописывать стандарт исключений для роботов (User-agent), директивы запрета и открытия доступа (Disallow и Allow) и Sitemap (указывается путь к карте сайта). А вот для Яндекса еще надо задать директиву Host (главное зеркало сайта), а также можно указать директивы Crawl-delay (минимальный период времени в секундах между загрузками страниц) и Clean-param (нужна, чтобы робот много раз не перезагружал дублирующуюся информацию, если адреса страниц сайта содержат динамические параметры, не влияющие на их содержимое).

Пример файла robots.txt для сайта на WordPress

Пример файла robots.txt для сайта на WordPress

Проверить корректность составления robots.txt можно в Вебмастере Яндекса или в Google Search Console с помощью встроенных инструментов.

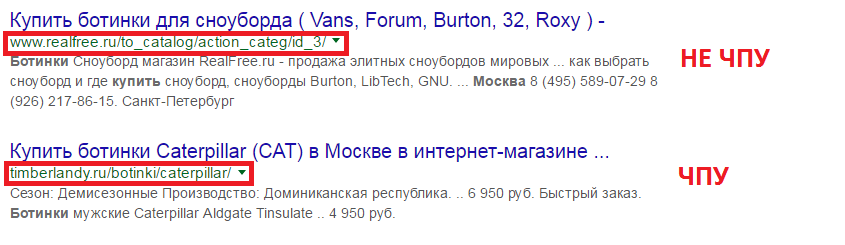

3. Настройка человекопонятных URL (ЧПУ)

ЧПУ (в английской интерпретации — friendly URL) — это URL, состоящие из набора понятных слов, а не отражающие файловую структуру сайта.

ЧПУ дают несколько преимуществ:

- по названию URL пользователь может предположить содержание страницы, что уменьшает показатель отказов;

- упрощается навигация по сайту;

- если в URL есть ключевое слово, то в результатах поиска оно подсвечивается жирным, что повышает кликабельность.

Для целей SEO обязательно стоит настроить ЧПУ до запуска сайта. В противном случае, если страницы проиндексируются, а потом вы решите настроить ЧПУ, то придется использовать редиректы со старых страниц, чтобы избежать дублей.

4. Исключение дублирования страниц

Если страницы имеют одинаковое содержимое, но разные URL, то для пользователей это одинаковые страницы, а вот для поисковиков — разные с дублирующимся контентом. Для продвижения сайта это нежелательное явление, особенно если дубли накапливаются как снежный ком. Поэтому еще на этапе разработки нужно предпринять меры по недопущению их появления.

Обычно дубли возникают из-за особенностей работы CMS или ошибок в процессе веб-разработки. Распространенные дубли:

- главная страница с www и без www;

- динамическое содержание сайта с идентификаторами ?, index.php, &view;

- URL со слешем в конце названия страницы и без него;

- страницы вывода на печать;

- страницы ответов на комментарии и т. д.

Разные дубли требуют разного подхода к устранению. Так, атрибут rel=«canonical» указывает на рекомендуемую для индексации страницу. Закрыть отдельные страницы от индексации можно с помощью метатега noindex. Также можно настроить 301 редирект для страниц с одинаковым содержимым.

Еще один метод — ручное удаление дублирующихся страниц или их исключение из поиска с помощью инструментов для вебмастеров от Яндекса и Google. Но он подходит, если страниц не много. А вот с помощью robots.txt с дублями не стоит бороться, ведь его директивы носят рекомендательный характер. Более подробно о борьбе с дублями можно прочитать в нашей информационной рассылке.

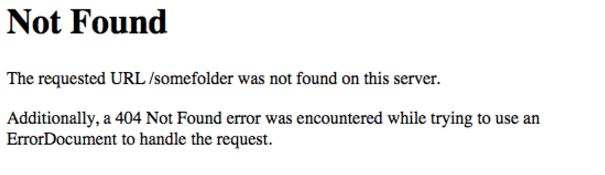

Страница ошибки 404

Бывает, что пользователь попадает на несуществующую страницу, в результате чего выдается ошибка 404 «Страница не найдена». Ошибка возникает по причине указания неправильного URL или удаления страницы администрацией ресурса. Если не создана страница ошибки 404, пользователь получит примерно такой результат:

Подобное сообщение сигнализирует непосвященному пользователю о том, что сайт не работает. Вряд ли кто-то будет пытаться «достучаться» до вас — пользователь просто уйдет к конкуренту. Но если вы создадите правильную страницу ошибки 404, то результат будет совсем другой: человек попадет на ваш сайт, где будет описано, по какой причине недоступна страница, предложены альтернативные пути.

Оформление страницы 404 сайта seopult.ru

Оформление страницы 404 сайта seopult.ru

При оформлении страницы 404 используйте интересную картинку или видео, позволяющие на секунду задержать внимание. Поясните, по какой причине возникла ошибка, разместите ссылки на разделы, на главную, строку поиска, одним словом, удержите пользователя.

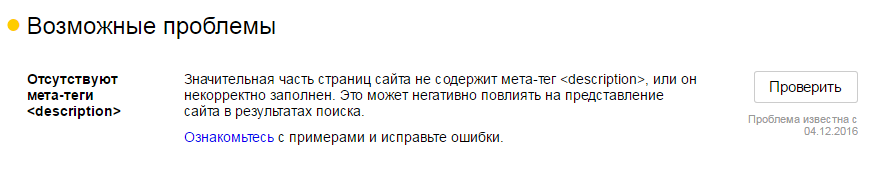

6. Метатеги Title, Description и Alt

Метатеги передают информацию поисковикам о содержании страниц. В Title указывается название страницы, в Description — краткое описание, в Alt — описание изображения. Поисковики по-разному используют информацию из метатегов. Например, Google использует информацию из Title и Description для формирования сниппета. А вот Яндекс может использовать, а может и не использовать.

Яндекс.Вебмастер указывает на отсутствие метатегов

Яндекс.Вебмастер указывает на отсутствие метатегов

В любом случае текст метатегов учитывают все поисковики при формировании выдачи, поэтому в них важно включать основные ключевые запросы со страницы. Как правильно оформить метатег Title, читайте в этой статье.

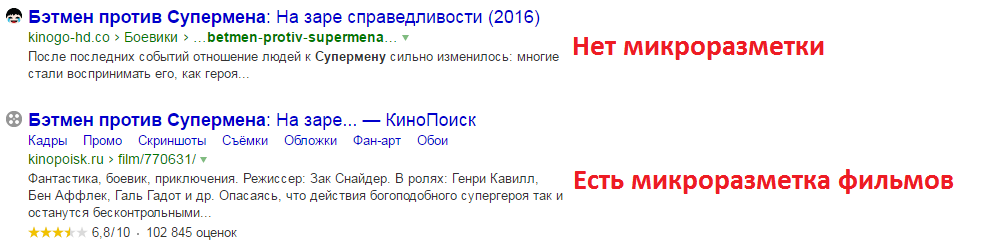

7. Микроразметка

Микроразметка помогает поисковикам сориентироваться в содержимом страницы. Ее лучше реализовать на этапе разработки сайта. Несмотря на то, что прямого влияния на ранжирование она не оказывает, она помогает улучшить вид сниппета, что повышает его кликабельность и поведенческие факторы.

Практическая реализация микроразметки возможна с помощью словарей schema.org, стандарта Open Graph, микроформатов. Каждый поисковик поддерживает определенный набор микроданных и на его основе формирует сниппет. Рекомендации по работе с schema.org вы найдете в данной публикации.

8. Мобильная адаптация

Адаптировать сайт для просмотра на мобильных устройствах важно именно на этапе разработки. Дизайн изначально должен прорабатываться с учетом удобства просмотра на разных экранах. Такие сайты выше ранжируются в мобильной выдаче, получают больше трафика, к ним более лояльны поисковики и пользователи. Реализовать адаптивность можно двумя способами: с помощью создания мобильной версии или адаптивного дизайна. Для поисковиков разницы нет — выбирайте тот вариант, который будет более удобен вашей аудитории.

Итак, теперь вы знаете, какие аспекты SEO надо учитывать на этапе разработки сайта. Правильная оптимизация позволит избежать лишних затрат в будущем, наложения фильтров со стороны поисковиков и даст возможность использовать весь потенциал сайта для получения выгодных позиций.

Однако если этап разработки уже давно пройден, а мысль о возможных скрытых ошибках вас не покидает, обязательно проведите SEO-аудит сайта. В SeoPult данная услуга доступна всего от 3000 рублей. Чтобы получить ее, нужно просто пройти регистрацию в Системе, создать проект и отправить заявку из раздела сайта “Персональный менеджер”.

Успешного продвижения!

Полный автопилот с указанием домена и бюджета или тонкая ручная настройка:

Запустить рекламу в PromoPult